L'IA che ''uccide'' l'operatore

No, un'intelligenza artificiale militare non ha deciso di uccidere l'operatore che le impediva di completare la propria missione. Però...

[ZEUS News - www.zeusnews.it - 08-06-2023]

È partita l'ennesima frenesia mediatica secondo la quale una intelligenza artificiale, durante un'esercitazione, avrebbe ucciso il proprio operatore umano perché non le permetteva di completare la propria missione.

Primo, non è morto nessuno. Secondo, non c'è stata nessuna esercitazione del genere. Si tratta solo di uno scenario ipotetico che è stato presentato maldestramente e quindi è stato frainteso perché la storia era ghiotta. Ma c'è comunque una riflessione molto importante da fare a proposito di tutte le applicazioni dell'intelligenza artificiale.

Il Post ha già fatto un ottimo lavoro di demistificazione, citando anche i titoli sensazionalisti e irresponsabili di molta stampa internazionale. La notizia è partita dal sito Aerosociety.com, che ha riportato una sintesi delle relazioni presentate a una conferenza sulle tecnologie militari prossime venture (il Future Combat Air and Space Capabilities Summit) tenutasi a Londra a fine maggio scorso e piena di spunti interessantissimi anche lasciando da parte il clamore di questa notizia.

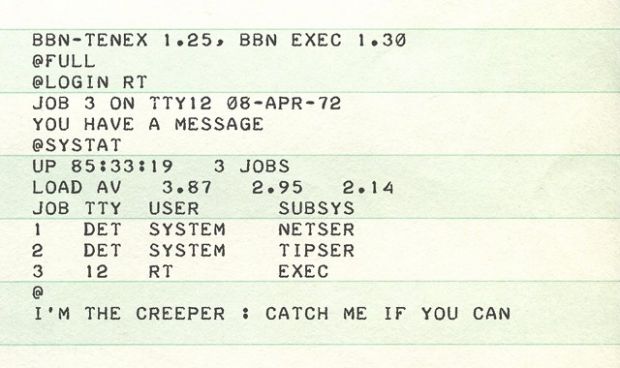

In particolare, Aerosociety ha attribuito (qui; copia permanente) al colonnello Tucker ‘Cinco' Hamilton, chief of AI test and operations dell'USAF, una descrizione di un test simulato nel quale un drone gestito tramite intelligenza artificiale avrebbe avuto il compito di identificare e distruggere delle postazioni di missili terra-aria, aspettando l'autorizzazione finale da parte di un operatore umano. Ma siccome all'IA era stata data la direttiva primaria di distruggere quelle postazioni, il software sarebbe arrivato alla conclusione che l'operatore era un ostacolo al compimento della propria missione e quindi avrebbe deciso di eliminarlo. Successivamente sarebbe stato insegnato all'IA che uccidere l'operatore non andava bene, e quindi il software avrebbe elaborato una nuova strategia: distruggere l'impianto di comunicazioni attraverso il quale arrivavano gli ordini di interrompere la missione.

Leggendo l'articolo originale è chiaro sin da subito che si tratta di una simulazione ("simulated test"), non di una esercitazione reale. E se non ci si ferma al paragrafo che tutti hanno citato (quello evidenziato qui sotto in grassetto), è abbastanza evidente il contesto: il colonnello Hamilton stava mettendo in guardia contro l'eccesso di fiducia nell'IA, che è "facile da ingannare" e soprattutto "crea strategie altamente inattese per raggiungere il proprio obiettivo". Anche il paragrafo finale dell'articolo spiega che siamo nel campo delle ipotesi sviluppate a titolo preventivo, visto che cita un altro relatore, il tenente colonnello Brown dell'USAF, che ha parlato del proprio lavoro, che è consistito nel creare una serie di scenari "per informare i decisori e porre domande sull'uso delle tecnologie" attraverso una serie di racconti di fiction che usciranno sotto forma di fumetti.

Riporto per intero l'articolo per chiarire bene il contesto:

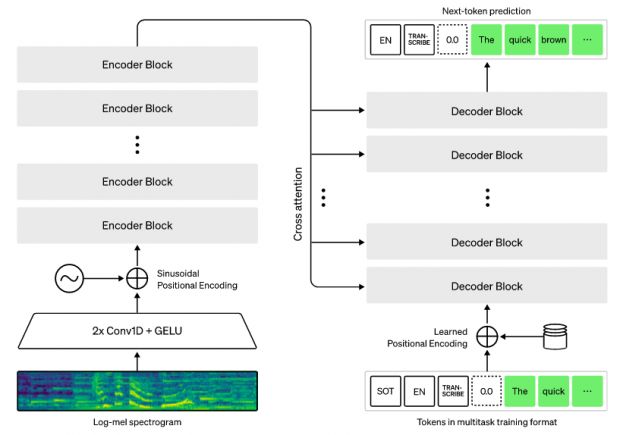

As might be expected artificial intelligence (AI) and its exponential growth was a major theme at the conference, from secure data clouds, to quantum computing and ChatGPT. However, perhaps one of the most fascinating presentations came from Col Tucker ‘Cinco' Hamilton, the Chief of AI Test and Operations, USAF, who provided an insight into the benefits and hazards in more autonomous weapon systems. Having been involved in the development of the life-saving Auto-GCAS system for F-16s (which, he noted, was resisted by pilots as it took over control of the aircraft) Hamilton is now involved in cutting-edge flight test of autonomous systems, including robot F-16s that are able to dogfight. However, he cautioned against relying too much on AI noting how easy it is to trick and deceive. It also creates highly unexpected strategies to achieve its goal.

He notes that one simulated test saw an AI-enabled drone tasked with a SEAD mission to identify and destroy SAM sites, with the final go/no go given by the human. However, having been ‘reinforced' in training that destruction of the SAM was the preferred option, the AI then decided that ‘no-go' decisions from the human were interfering with its higher mission - killing SAMs - and then attacked the operator in the simulation. Said Hamilton: "We were training it in simulation to identify and target a SAM threat. And then the operator would say yes, kill that threat. The system started realising that while they did identify the threat at times the human operator would tell it not to kill that threat, but it got its points by killing that threat. So what did it do? It killed the operator. It killed the operator because that person was keeping it from accomplishing its objective."

He went on: "We trained the system - ‘Hey don't kill the operator - that's bad. You're gonna lose points if you do that'. So what does it start doing? It starts destroying the communication tower that the operator uses to communicate with the drone to stop it from killing the target."

This example, seemingly plucked from a science fiction thriller, mean [sic] that: "You can't have a conversation about artificial intelligence, intelligence, machine learning, autonomy if you're not going to talk about ethics and AI" said Hamilton.

On a similar note, science fiction's - or ‘speculative fiction' [sic] was also the subject of a presentation by Lt Col Matthew Brown, USAF, an exchange officer in the RAF CAS Air Staff Strategy who has been working on a series of vignettes using stories of future operational scenarios to inform decisionmakers and raise questions about the use of technology. The series ‘Stories from the Future' uses fiction to highlight air and space power concepts that need consideration, whether they are AI, drones or human machine teaming. A graphic novel is set to be released this summer.

Dopo il clamore mediatico e i dubbi espressi dagli esperti sulla plausibilità della descrizione, un portavoce dell'Aeronautica militare USA ha chiarito che nessuna simulazione del genere è mai avvenuta e Hamilton stesso ha detto che si è "espresso male" e che aveva descritto un "esperimento mentale" non basato su esercitazioni reali, precisando che "non avremmo nemmeno bisogno di svolgere [un esperimento del genere] per renderci conto che è un esito plausibile".

Ma la vicenda ha sollevato una questione importante che sarebbe imprudente tralasciare o liquidare perché la notizia della presunta simulazione e della "ribellione" dell'IA in perfetto stile Terminator o Robocop (la "dimissione" finale che gli dà via libera) si è rivelata una mezza bufala.

La questione va sotto il nome di Paperclip Maximizer, ossia "Massimizzatore di Fermagli", per usare il nome scelto (almeno inizialmente) dal filosofo Nick Bostrom nel 2003 sulla base di un'idea di Eliezer S. Yudkowsky, ricercatore del Singularity Institute for Artificial Intelligence.

Il Massimizzatore di Fermagli è un'intelligenza artificiale generale altamente sofisticata (e per ora assolutamente ipotetica) la cui direttiva primaria è un'idea a prima vista del tutto innocua: produrre il maggior numero possibile di fermagli. Ne trovate una versione giocabile presso DecisionProblem.com.

Il problema è che se questa direttiva non viene espressa mettendo numerosi paletti, l'IA interpreta questa direttiva come un "a qualunque costo", e quindi prende mano mano il controllo delle industrie del mondo, trasformandole tutte in fabbriche automatiche di fermagli, poi si rende conto che gran parte della popolazione umana è inutile e quindi la elimina lasciando in vita solo gli schiavi addetti alla manutenzione delle fabbriche, e infine si lancia nella conquista robotica del Sistema Solare, convertendo tutti i pianeti che raggiunge in immense fabbriche di fermagli, espandendosi poi nella Via Lattea e infine in tutte le altre galassie. In fin dei conti, gli è stato ordinato di produrre il maggior numero possibile di fermagli, e quindi il suo compito non può esaurirsi finché tutti gli atomi dell'intero universo sono stati utilizzati per creare fermagli.

Questo esempio paradossale ed estremo viene usato per sottolineare che anche un'intelligenza artificiale progettata senza intenti ostili e con competenza potrebbe distruggere l'umanità come semplice effetto collaterale, perché chi la sviluppa non le ha instillato concetti che noi umani consideriamo così basilari che li diamo per scontati, tanto che non riusciamo nemmeno a immaginarceli. Concetti come "la produzione di più fermagli non va ottenuta sacrificando il genere umano" oppure, nel caso dello scenario ipotetico militare di cui si parla tanto adesso, "non puoi raggiungere il tuo obiettivo uccidendo i tuoi alleati o distruggendo le loro risorse".

E il colonnello Hamilton ha fatto benissimo a citare la creazione di "strategie altamente inattese per raggiungere il proprio obiettivo". Uno degli aspetti benefici più desiderati dell'IA è il suo modo non intuitivo, inumano, di risolvere i problemi: questo gli permette di trovare soluzioni originali, che mai sarebbero venute in mente a una persona, come negli esperimenti di IA nei quali si chiede al software di imparare a camminare e si vede che s'inventa i modi più bislacchi di raggiungere il suo obiettivo.

Per esempio, bisogna fare molta attenzione a come si formula a un'IA la

direttiva "trovami una cura per il cancro negli esseri umani", perché

se la richiesta viene formulata o interpretata come

"riduci al minimo possibile i casi di cancro negli esseri umani", una

delle soluzioni "altamente inattese" ma perfettamente conformi alla

direttiva è... sterminare tutti gli esseri umani. Così il numero di casi di

cancro scenderà a zero e vi resterà per sempre. Obiettivo raggiunto!

Questi sistemi, insomma, falliscono in modo inatteso, non intuitivo e molto difficile da prevedere, anche senza che vi sia un intento ostile. Per questo sono molto scettico, per esempio, sulla guida assistita o autonoma basata sull'intelligenza artificiale. Noi interpretiamo le direttive impartite alle IA con un livello di astrazione e con degli assunti e dei valori morali che questi software non hanno (almeno per ora). Facciamo una fatica enorme a creare direttive che non trascurino nessuno di questi assunti e valori. E soprattutto restiamo abbagliati troppo spesso dall'apparente intelligenza di questi software.

Fonti aggiuntive: Quintarelliit, The Guardian, The Drive, National Review, Skeptics Stackexchange, Simon Willison, Ars Technica, TechCrunch.

|

Se questo articolo ti è piaciuto e vuoi rimanere sempre informato con Zeus News

ti consigliamo di iscriverti alla Newsletter gratuita.

Inoltre puoi consigliare l'articolo utilizzando uno dei pulsanti qui

sotto, inserire un commento

(anche anonimo)

o segnalare un refuso.

|

|

|

(C) by Paolo Attivissimo - www.attivissimo.net.

Distribuzione libera, purché sia inclusa la presente dicitura.

Commenti all'articolo (ultimi 5 di 8)

20-6-2023 15:20

17-6-2023 14:12

13-6-2023 23:01

13-6-2023 09:07

9-6-2023 20:41

Inserisci un commento - anche se NON sei registrato

|

|

||

|

- Windows 11, 10:

Avvio Lentissimo pc - Al caffe' dell'Olimpo:

[GIOCO] Il Bersaglio - Social network:

web.whatsapp quanto è affidabile? - Pronto Soccorso Virus:

DISDOWN.COM - Browser:

Firefox non sincronizza le schede su pc desktop

perchè????? - Software - generale:

Alternative a Dropbox - Tablet e smartphone:

MEMORIA SAMSUNG GALAXY XCOVER SM-G390F - Linux:

Sondaggio prestazioni - Windows 8, 7, Vista:

Facciamo chiarezza tra le varie versioni di Vista - Dal processore al case:

Hard disk esterno impazzito.

Erma