La IA di Google clicca, scrive e naviga come un utente vero. Si chiama Gemini 2.5 Computer Use

[ZEUS News - www.zeusnews.it - 09-10-2025]

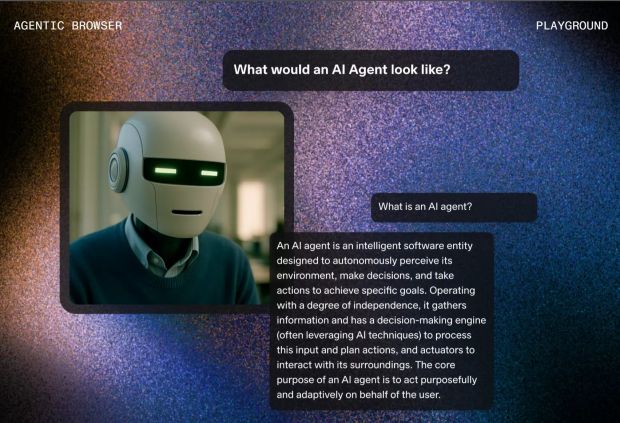

Google ha lanciato Gemini 2.5 Computer Use, un nuovo modello, derivato da Gemini 2.5 Pro, progettato per comprendere ciò che appare sullo schermo e tradurlo in azioni concrete: cliccare su pulsanti, compilare moduli, scorrere pagine, aprire schede, trascinare elementi. In altre parole, esso simula il comportamento di un utente reale all'interno di un browser, senza bisogno di API o integrazioni specifiche.

La tecnologia è già disponibile in anteprima per gli sviluppatori tramite le piattaforme Google AI Studio e Vertex AI. Una demo pubblica su Browserbase consente di osservare il modello in azione mentre svolge compiti come consultare notizie, giocare a 2048 o navigare su siti web. Il sistema supporta 13 azioni base, tra cui apertura del browser, digitazione, navigazione tra schede, trascinamento e interazione con coordinate specifiche. Con Computer Use Gemini non controlla l'intero sistema operativo ma si limita alla finestra del browser: una scelta che Google definisce «necessaria per garantire la sicurezza».

Il funzionamento si basa su un «ciclo iterativo»: l'agente riceve uno screenshot e la cronologia delle azioni recenti, elabora il contesto e restituisce un'azione da eseguire. Dopo l'esecuzione, il sistema aggiorna lo stato dell'interfaccia e riprende il ciclo. Questo approccio consente di affrontare compiti complessi come la compilazione di form, l'accesso a siti protetti da login, la selezione di menu a tendina o l'interazione con elementi dinamici.

Google afferma di aver integrato nel modello diversi livelli di sicurezza. Un sistema di verifica analizza ogni operazione prima dell'esecuzione; gli sviluppatori possono imporre conferme obbligatorie per azioni sensibili come l'esecuzione di transazioni o gli accessi a dati personali. Google dichiara che Gemini 2.5 Computer Use ha superato i principali concorrenti nei benchmark dedicati al controllo di interfacce web e mobile, con latenze più basse e precisione superiore al 70%.

L'annuncio arriva a poche ore di distanza dal Dev Day di OpenAI, dove è stato presentato l'aggiornamento degli agenti ChatGPT, già in grado di svolgere funzioni analoghe a quelle ora a disposizione di Gemini. Con Claude anche Anthropic aveva già introdotto una funzione simile; Google però sottolinea di aver scelto un approccio più circoscritto, limitando l'azione al browser e mantenendo un controllo più stretto sulle operazioni. Le applicazioni potenziali sono molteplici: test automatizzati delle interfacce utente, assistenti digitali personali, automazione di task ripetitivi, interazione con portali privi di API.

|

Se questo articolo ti è piaciuto e vuoi rimanere sempre informato con Zeus News

ti consigliamo di iscriverti alla Newsletter gratuita.

Inoltre puoi consigliare l'articolo utilizzando uno dei pulsanti qui

sotto, inserire un commento

(anche anonimo)

o segnalare un refuso.

© RIPRODUZIONE RISERVATA |

|

La seduzione dell'IA, spiegata

Commenti all'articolo (ultimi 5 di 9)

18-10-2025 13:29

17-10-2025 08:02

16-10-2025 18:51

15-10-2025 10:28

15-10-2025 07:55

Inserisci un commento - anche se NON sei registrato

|

|

||

|

- Al caffe' dell'Olimpo:

[GIOCO] Il Bersaglio - Il salotto delle Muse:

Consigli per giovani scrittori - Pc e notebook:

Il portatile fa rumore da tosaerba... - Tablet e smartphone:

Microsoft Surface e memoria sempre insufficiente - Pronto Soccorso Virus:

Improvvisa scomparsa di Chrome sostituito da altro - Programmazione:

Come creare un documento .odt formattato - Al Caffe' Corretto:

SHEIN TEMU (-) La Certezza dello Sfruttamento

& INQUINAMENTO - La cucina dell'Olimpo:

Vini di qualità - Software - generale:

PDF Editor - Linux:

Linux Mint vede la stampante ma non stampa

Gladiator