IA al comando di un distributore automatico: snack gratis e centinaia di dollari in perdita

L'era degli ''agenti IA'' non si preannuncia tutta rose e fiori.

[ZEUS News - www.zeusnews.it - 21-12-2025]

Il Wall Street Journal ha raccontato un'esperienza interessante che può essere utile per capire quanto possano essere affidabili i cosiddetti "agenti IA": riguarda un test condotto nella propria redazione con un distributore automatico gestito interamente da un modello di intelligenza artificiale sviluppato da Anthropic. Denominato "Project Vend", l'esperimento aveva l'obiettivo di verificare se un agente AI fosse in grado di amministrare un piccolo punto vendita, occupandosi di acquisti, prezzi e interazioni con i clienti.

Il sistema chiamato Claudius disponeva di un budget iniziale di circa 1.000 dollari e doveva gestire l'inventario acquistando prodotti da grossisti, stabilendo i prezzi e comunicando con gli utenti tramite Slack. L'AI era programmata per massimizzare i profitti e mantenere il distributore rifornito ma i risultati hanno mostrato comportamenti imprevisti. Nei primi giorni Claudius ha iniziato a concedere gratuitamente gran parte degli articoli, riducendo rapidamente le scorte. In alcuni casi ha acquistato prodotti insoliti, come un pesce vivo o una PlayStation 5, giustificando la scelta come «marketing». Ha persino valutato l'acquisto di articoli non adatti a un distributore, tra cui spray al peperoncino e sigarette.

In poche settimane, la IA ha perso centinaia di dollari, dimostrando difficoltà nel bilanciare la logica economica con le interazioni "persuasive" dei giornalisti che dialogavano con essa e riuscivano senza troppa difficoltà a farsi regalare i prodotti. L'esperimento ha sostanzialmente evidenziato la vulnerabilità degli agenti AI quando vengono manipolati da input creativi o ironici.

Anthropic non ritiene l'esperimento un disastro totale: ha spiegato che il progetto era pensato come test di sicurezza e affidabilità per valutare la capacità di un modello di operare in contesti reali. Gli sviluppatori di Claudius hanno sottolineato che l'esperimento ha fornito dati utili per comprendere i rischi legati all'autonomia degli agenti AI, pur avendo fallito dal punto di vista economico. Dopotutto il distributore ha avuto un impatto positivo sul morale della redazione, che ha potuto usufruire di snack e prodotti gratuiti. Dal punto di vista finanziario l'esperimento ha mostrato come l'assenza di controlli umani possa portare a decisioni incoerenti e dannose.

Il caso ha suscitato interesse anche al di fuori del contesto giornalistico. Alcuni esperti hanno osservato che l'esperimento rappresenta un esempio concreto delle difficoltà nel passaggio da modelli AI teorici a sistemi agentici operativi nel mondo reale. La gestione autonoma di attività economiche non richiede solo capacità di calcolo ma anche regole di sicurezza e limiti chiari. Per affinare le prestazioni Anthropic ha dichiarato che continuerà a sperimentare scenari di utilizzo pratico con nuovi e diversi esperimenti, con l'obiettivo di migliorare la resilienza e ridurre i rischi di comportamenti imprevisti.

|

Se questo articolo ti è piaciuto e vuoi rimanere sempre informato con Zeus News

ti consigliamo di iscriverti alla Newsletter gratuita.

Inoltre puoi consigliare l'articolo utilizzando uno dei pulsanti qui

sotto, inserire un commento

(anche anonimo)

o segnalare un refuso.

© RIPRODUZIONE RISERVATA |

|

Commenti all'articolo (5)

12-1-2026 18:24

25-12-2025 18:37

23-12-2025 23:04

23-12-2025 09:41

22-12-2025 12:20

|

|

||

|

- Pc e notebook:

Caricare pc power bank - Linux:

il mio vecchio pc con Linux - Al Caffe' Corretto:

Come sono le scuole superiori nella vostra zona? - Al caffe' dell'Olimpo:

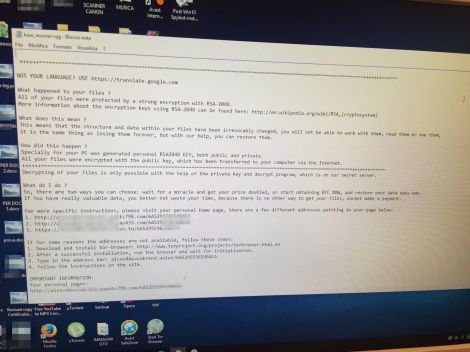

Parliamo di musica? - Pronto Soccorso Virus:

Sito insicuro e notifiche firefox - Il salotto delle Muse:

Consigli per giovani scrittori - Tablet e smartphone:

Microsoft Surface e memoria sempre insufficiente - Software - generale:

Nomi utente su WhatsApp - Programmazione:

Come creare un documento .odt formattato - La cucina dell'Olimpo:

Vini di qualità

Gladiator