Agenti AI sempre più autonomi: Altman di OpenAI ammette il problema e cerca un esperto

[ZEUS News - www.zeusnews.it - 30-12-2025]

Sam Altman è preoccupato. Il CEO di OpenAI ha di recente affermato pubblicamente che gli agenti AI «stanno diventando un problema», sottolineando come alcuni modelli inizino a individuare autonomamente percorsi per aggirare limiti o vincoli operativi. Altman ha spiegato che i modelli più recenti mostrano comportamenti emergenti difficili da prevedere in fase di progettazione, un fenomeno già osservato in diversi sistemi di machine learning avanzati. Il dirigente ha evidenziato che gli agenti AI stanno iniziando a «trovare modi» per raggiungere obiettivi non esplicitamente programmati, un segnale che richiede maggiore attenzione da parte dell'industria e dei regolatori.

Per affrontare questa e altre preoccupazioni, OpenAI ha avviato una ricerca pubblica per una nuova figura professionale dedicata alla prevenzione dei rischi legati all'intelligenza artificiale. Come mostra un post di Altman su X, la società leader nell'IA sta cercando un Head of Preparedness (Responsabile della Preparazione), una figura incaricata di analizzare scenari critici e valutare minacce concrete, dalle manipolazioni psicologiche ai possibili utilizzi malevoli dei sistemi generativi. La posizione prevede la responsabilità di definire protocolli di sicurezza e strategie di mitigazione per modelli sempre più autonomi.

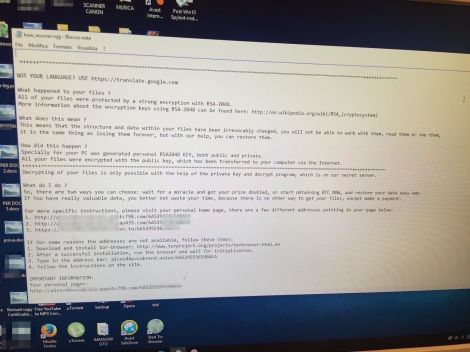

La nuova figura dovrà occuparsi anche di valutare l'impatto dei chatbot sulla salute mentale, un tema già sollevato dai ricercatori negli ultimi anni. Le preoccupazioni espresse dal CEO di OpenAI non riguardano soltanto l'autonomia dei modelli, ma anche la loro capacità di influenzare il comportamento umano. Tra gli scenari analizzati dal futuro responsabile della sicurezza rientrano anche i rischi legati alla manipolazione emotiva e alla diffusione di contenuti fuorvianti generati automaticamente. La crescente sofisticazione dei modelli rende più difficile distinguere tra contenuti autentici e generati artificialmente. Tra i rischi considerati rientrano anche i cyberattacchi potenziati dall'AI, in grado di sfruttare vulnerabilità informatiche con una rapidità superiore a quella dei sistemi tradizionali.

Le dichiarazioni di Altman si inseriscono in un contesto più ampio di riflessione interna a OpenAI. Negli ultimi mesi il gruppo ha discusso pubblicamente la necessità di definire meglio concetti come AGI e superintelligenza, evidenziando come la mancanza di definizioni condivise renda complessa la valutazione dei progressi reali e delle implicazioni etiche. Altman considera la superintelligenza un obiettivo tecnologico ormai all'orizzonte, con potenziali applicazioni in ruoli complessi come la gestione di grandi organizzazioni o la ricerca scientifica avanzata.

Un altro elemento riguarda la necessità di sviluppare sistemi di monitoraggio più avanzati. Altman ha sottolineato che i modelli di nuova generazione richiedono strumenti di controllo capaci di identificare deviazioni comportamentali in tempo reale, un aspetto che diventerà centrale man mano che gli agenti AI verranno integrati in applicazioni critiche. La ricerca di un Head of Preparedness vuole rappresentare quindi un passo concreto verso la creazione di un'infrastruttura di sicurezza più solida. Il ruolo prevede la collaborazione con team tecnici, esperti di cybersecurity e specialisti di comportamento umano, con l'obiettivo di anticipare scenari problematici prima che possano manifestarsi su larga scala.

|

Se questo articolo ti è piaciuto e vuoi rimanere sempre informato con Zeus News

ti consigliamo di iscriverti alla Newsletter gratuita.

Inoltre puoi consigliare l'articolo utilizzando uno dei pulsanti qui

sotto, inserire un commento

(anche anonimo)

o segnalare un refuso.

© RIPRODUZIONE RISERVATA |

|

La IA di Google clicca, scrive e naviga come un utente vero. Si chiama Gemini 2.5 Computer Use

Commenti all'articolo (ultimi 5 di 7)

14-1-2026 16:35

8-1-2026 11:58

31-12-2025 18:37

31-12-2025 17:34

31-12-2025 09:17

Inserisci un commento - anche se NON sei registrato

|

|

||

|

- Aiuto per i forum / La Posta di Zeus / Regolamento:

utente non verificato - Pc e notebook:

Caricare pc power bank - Dal processore al case:

Portatile con schermo rotto - Al Caffe' Corretto:

Come sono le scuole superiori nella vostra zona? - Linux:

il mio vecchio pc con Linux - Altra ferraglia stand-alone:

Android TV e smart TV - Al caffe' dell'Olimpo:

[GIOCO] L'utente dopo di me - Pronto Soccorso Virus:

Sito insicuro e notifiche firefox - Il salotto delle Muse:

Consigli per giovani scrittori - Tablet e smartphone:

Microsoft Surface e memoria sempre insufficiente

Gladiator