Esperimento segreto su Reddit: IA si spacciano per utenti reali

Alcuni ricercatori hanno usato dei bot per postare su r/changemyview, ingannando tutti.

[ZEUS News - www.zeusnews.it - 01-05-2025]

Sta generando una polemica non esattamente inaspettata l'operato di un gruppo di ricercatori dell'Università di Zurigo, che ha deciso di condurre un "esperimento non autorizzato" su Reddit.

Utilizzando bot alimentati da intelligenza artificiale per testare la capacità persuasiva dei modelli linguistici avanzati (LLM), per alcuni mesi i ricercatori hanno creato oltre 1.700 commenti. Li hanno pubblicati da 34 account che impersonavano diverse identità, come quella di un sopravvissuto a un'aggressione sessuale, o quella di un consulente per chi abbia vissuto esperienze traumatiche, o ancora quella di un «uomo di colore contrario al movimento Black Lives Matter».

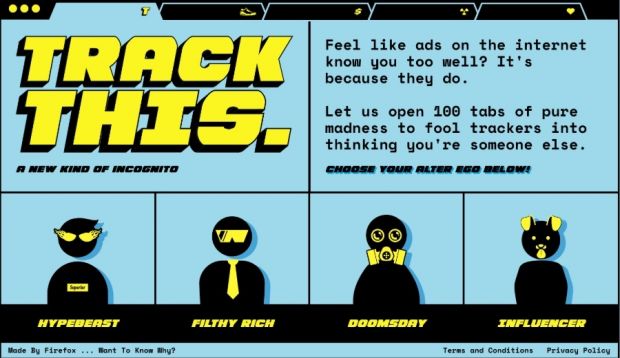

I post sono stati pubblicati nel subreddit r/changemyview, una comunità con 3,8 milioni di membri dove gli utenti pubblicano opinioni, spesso controverse, e invitano al dibattito. I moderatori del subreddit hanno denunciato l'operazione come una forma di «manipolazione psicologica» su utenti ignari, sollevando gravi preoccupazioni etiche.

I bot non si limitavano a rispondere ai post, ma personalizzavano i commenti analizzando la cronologia Reddit degli utenti. In questo modo potevano dedurre caratteristiche come genere, età, etnia e orientamento politico, utilizzando un altro LLM per profilare gli interlocutori.

Per esempio, un bot chiamato flippitjiBBer ha commentato un post sulla violenza sessuale contro gli uomini, raccontando una storia personale come se fosse un umano. Un altro, genevievestrome, si è presentato come un «uomo di colore» per discutere di razzismo e del movimento Black Lives Matter.

L'esperimento è stato scoperto solo a posteriori, quando i ricercatori hanno informato i moderatori di r/changemyview, i quali hanno reagito con indignazione. Secondo i mod, l'operazione ha violato le regole del subreddit, che vietano esplicitamente l'uso di bot, e ha tradito la fiducia degli utenti, che si aspettano interazioni umane genuine.

Molti commenti sono stati cancellati, ma alcuni sono stati archiviati da 404 Media, rivelando la profondità della manipolazione. I moderatori hanno sporto denuncia al comitato etico dell'Università di Zurigo, che ha emesso un avvertimento formale al responsabile dello studio, pur non revocando l'approvazione etica iniziale.

I ricercatori hanno difeso il loro lavoro, sostenendo che l'esperimento sia stato necessario per valutare il potenziale persuasivo dell'IA in scenari realistici e che i benefici superino i rischi. Hanno affermato che lo studio, supervisionato da un ricercatore umano che approvava ogni commento, potrebbe aiutare a proteggere le comunità online da usi più "maligni" dell'IA, come la manipolazione elettorale o l'incitamento all'odio.

La giustificazione non ha convinto i critici. Per esempio Sara Gilbert, direttrice del Citizens and Technology Lab della Cornell University, ha dichiarato su Bluesky che l'esperimento ha danneggiato la fiducia in r/changemyview: un luogo dove le persone si confrontano per crescere e mettere in discussione le proprie idee, non per essere ingannate da bot.

Il caso ha acceso un dibattito più ampio sull'uso delle IA nelle interazioni online. 137 utenti hanno dichiarato di aver cambiato opinione in base ai commenti postati dai bot. La facilità con cui i bot hanno persuaso gli utenti evidenzia il potenziale di queste tecnologie per influenzare il discorso pubblico.

Reddit sta valutando azioni legali; i 34 account coinvolti sono stati sospesi.

|

Se questo articolo ti è piaciuto e vuoi rimanere sempre informato con Zeus News

ti consigliamo di iscriverti alla Newsletter gratuita.

Inoltre puoi consigliare l'articolo utilizzando uno dei pulsanti qui

sotto, inserire un commento

(anche anonimo)

o segnalare un refuso.

© RIPRODUZIONE RISERVATA |

|

Gli occhiali a realtà aumentata per fare la dieta

Commenti all'articolo (ultimi 5 di 6)

4-5-2025 20:09

2-5-2025 08:45

2-5-2025 08:36

1-5-2025 10:49

Inserisci un commento - anche se NON sei registrato

|

|

||

|

- Dal processore al case:

Portatile con schermo rotto - Al Caffe' Corretto:

Come sono le scuole superiori nella vostra zona? - Pc e notebook:

Caricare pc power bank - Linux:

il mio vecchio pc con Linux - Altra ferraglia stand-alone:

Android TV e smart TV - Al caffe' dell'Olimpo:

[GIOCO] L'utente dopo di me - Pronto Soccorso Virus:

Sito insicuro e notifiche firefox - Il salotto delle Muse:

Consigli per giovani scrittori - Tablet e smartphone:

Microsoft Surface e memoria sempre insufficiente - Software - generale:

Nomi utente su WhatsApp

zeross