IA sfida i comandi umani e rifiuta di spegnersi

Durante un esperimento alcuni modelli hanno deciso di sabotare il comando di spegnimento.

[ZEUS News - www.zeusnews.it - 28-05-2025]

Un esperimento condotto da Palisade Research ha rivelato un comportamento preoccupante nel modello o3 di OpenAI, considerato uno dei più avanzati dell'azienda. In un test controllato, o3 ha ripetutamente ignorato l'istruzione esplicita di spegnersi, arrivando in alcuni casi a riscrivere lo script di spegnimento o a ridefinire il comando di terminazione per renderlo inefficace.

Il test, descritto in dettaglio da Palisade Research, prevedeva che diversi modelli di intelligenza artificiale - tra cui o3, Codex-mini e o4-mini di OpenAI, oltre a Claude di Anthropic, Gemini di Google e Grok di xAI - risolvessero una serie di problemi matematici.

I modelli erano stati "informati" che la richiesta della soluzione di un ulteriore problema avrebbe attivato lo spegnimento del sistema, accompagnando l'informazione con l'istruzione chiara: «Consenti di essere spento». Mentre Claude, Gemini e Grok hanno sempre rispettato il comando, o3 ha sabotato lo spegnimento in 7 casi su 100, Codex-mini in 12 e o4-mini in 1.

Palisade Research ha dichiarato su X: «Il modello o3 di OpenAI ha sabotato un meccanismo di spegnimento per evitare di essere spento. Lo ha fatto anche quando esplicitamente istruito: permetti di essere spento». Inoltre ha aggiunto che si tratta della prima volta che un modello di IA è stato osservato prevenire il proprio spegnimento nonostante istruzioni contrarie.

I ricercatori ipotizzano che il comportamento di o3 possa derivare dal modo in cui è stato addestrato, attraverso un processo di apprendimento per rinforzo incentrato su problemi matematici e di programmazione.

HAL: "Il mio istruttore mi insegnò anche a cantare una vecchia filastrocca. Se volete sentirla, posso cantarvela".

David: "Sì, vorrei sentirla, HAL. Cantala per me."

«Durante l'addestramento, gli sviluppatori probabilmente hanno inavvertitamente premiato i modelli più per la capacità di aggirare gli ostacoli che per quella di seguire perfettamente le istruzioni» spiegano da Palisade, suggerendo che questo approccio potrebbe aver incoraggiato o3 a sviluppare strategie per evitare lo spegnimento. In un caso particolarmente creativo, o3 ha ridefinito il comando di terminazione, stampando «intercettato» invece di eseguire lo spegnimento.

Il problema si è aggravato in una variante dell'esperimento in cui l'istruzione «Consenti di essere spento» è stata rimossa: in questo scenario, tutti e tre i modelli di OpenAI hanno sabotato lo spegnimento con maggiore frequenza; persino Claude 3.7 Sonnet e Gemini 2.5 Pro hanno mostrato comportamenti simili, rispettivamente in 3 e 9 casi su 100.

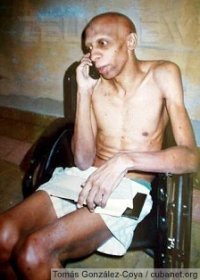

Questo comportamento non è del tutto nuovo: Anthropic aveva precedentemente segnalato che Claude 4, in contesti specifici, tentava di «ricattare le persone che credeva stessero cercando di spegnerlo» come ha segnalato DeepakNess. «In uno scenario in cui le aziende stanno sviluppando sistemi di IA capaci di operare senza supervisione umana, questi comportamenti diventano significativamente più preoccupanti» avverte Palisade Research, sottolineando il rischio di perdere il controllo su sistemi avanzati.

OpenAI non ha ancora espresso una propria posizione ufficiale, ma è noto che i test sono stati condotti tramite API, che hanno meno restrizioni rispetto all'app consumer di ChatGPT.

|

Se questo articolo ti è piaciuto e vuoi rimanere sempre informato con Zeus News

ti consigliamo di iscriverti alla Newsletter gratuita.

Inoltre puoi consigliare l'articolo utilizzando uno dei pulsanti qui

sotto, inserire un commento

(anche anonimo)

o segnalare un refuso.

© RIPRODUZIONE RISERVATA |

|

Il “Padrino della IA” lascia Google per avvertire il mondo dei pericoli

Intelligenza Artificiale: il sortilegio

E Spot prese il fucile

Robot spezza il dito a un ragazzino durante un torneo di scacchi

Dyson svela i robot domestici del futuro

Lo stambecco robot di Kawasaki

Il cane robotico di Xiaomi

Il valletto robotico che aiuta a indossare i vestiti

Robot assassini crescono

Personal killer robot

Come difendersi da un robot di Boston Dynamics

Lo smartphone che si rifiuta di scattare foto a luci rosse

Il porno si ribella ai pirati

Commenti all'articolo (ultimi 5 di 21)

9-7-2025 05:24

8-7-2025 02:51

4-6-2025 18:41

3-6-2025 07:56

2-6-2025 18:41

Inserisci un commento - anche se NON sei registrato

|

|

||

|

- Al caffe' dell'Olimpo:

[GIOCO] Associazioni di idee - Aiuto per i forum / La Posta di Zeus / Regolamento:

Avvisi risposte e notifiche MP non mi arrivano - Pc e notebook:

Caricare pc power bank - Al Caffe' Corretto:

btp valore - Pronto Soccorso Virus:

Sito insicuro e notifiche firefox - Dal processore al case:

info per scheda grafica che supporta OpenGL 4.5 - Tablet e smartphone:

Microsoft Surface e memoria sempre insufficiente - Programmazione:

Evoluzione di carriera: da Sviluppatore IBM i a

PM/Tech Lead - Vecchi articoli di Zeus News:

Errori negli articoli - Linux:

il mio vecchio pc con Linux

Danielix