IA e Modelli linguistici, la loro capacità di ragionare è solo un ''fragile miraggio''

Uno studio smonta i progressi apparenti delle intelligenze artificiali: non comprendono, ma si limitano a riproporre gli schemi su cui sono state addestrate.

[ZEUS News - www.zeusnews.it - 12-08-2025]

Un recente studio condotto da ricercatori delle università di Princeton e UC Berkeley, pubblicato in pre-print su arXiv, ha messo in luce una limitazione significativa dei grandi modelli linguistici (LLM), come quelli che alimentano assistenti AI avanzati: nonostante la loro capacità di generare testi fluidi e convincenti, questi modelli mostrano gravi carenze nel ragionamento logico e nell'inferenza, producendo spesso quello che i ricercatori definiscono «fluent nonsense» (discorsi scorrevoli ma privi di senso).

Lo studio si concentra sul fenomeno del "ragionamento simulato" degli LLM, ovvero la loro apparente capacità di seguire catene logiche di pensiero (chain-of-thought reasoning), un aspetto sottolineato particolarmente al momento del lancio di alcuni modelli recenti, come Grok 4 e GPT-5. I ricercatori hanno testato modelli come quelli di OpenAI, Google e Meta, scoprendo che le loro prestazioni peggiorano in modo significativo quando devono generalizzare andando al di là dei dati su cui sono stati addestrati. Per esempio, in compiti che richiedono di applicare regole logiche a nuovi scenari, gli LLM tendono a produrre risposte che sembrano corrette in superficie ma che, a un'analisi più approfondita, risultano incoerenti o errate. Questo problema è particolarmente evidente quando i modelli sono sottoposti a test di logica formale o a domande che richiedono un ragionamento astratto, come dimostrato da esperimenti che hanno messo in luce errori sistematici in problemi matematici o di deduzione.

Un aspetto interessante emerso dalla ricerca è che il processo di ottimizzazione, come il fine tuning o il rinforzo con feedback umano (RLHF), può addirittura peggiorare queste carenze. Ciò avviene perché gli LLM sono progettati per massimizzare la probabilità di generare sequenze di parole plausibili, non per verificare la correttezza logica delle loro affermazioni. Come sottolineato da un rapporto di Nature, gli LLM eccellono nel sintetizzare informazioni e nel generare testi che imitano il ragionamento umano, ma non riescono a replicare il processo di inferenza che sta alla base della vera comprensione.

Le implicazioni di queste limitazioni sono rilevanti in diversi ambiti. Per esempio, nel settore scientifico, dove giganti come Microsoft stanno esplorando sistemi AI auto-adattivi per supportare la ricerca, la mancanza di un ragionamento logico affidabile potrebbe compromettere l'accuratezza delle analisi. Analogamente, in contesti come la ricerca su Google, dove le AI Overview sono sempre più diffuse, errori logici potrebbero portare a informazioni fuorvianti per gli utenti.

I modelli che seguono il chain-of-thought (CoT) reasoning - scrivono i ricercatori - sono soltanto «una forma sofisticata di riconoscimento degli schemi» che «peggiora in modo sostanziale» quando viene portata al di là, anche di poco, del proprio campo di addestramento. E la capacità di creare «sciocchezze scorrevoli» genera «una falsa aura di affidabilità» che non regge davanti a un esame serio, ma che potrebbe trarre in inganno i meno provveduti. Insomma, gli enormi progressi apparenti compiuti dalle IA sarebbero «in gran parte un fragile miraggio» che va in pezzi rapidamente: «anziché dimostrare una vera comprensione del testo, il ragionamento CoT sembra consistere in una ripetizione degli schemi appresi durante l'addestramento».

Nonostante queste criticità, gli LLM continuano a essere strumenti potenti in ambiti che non richiedono un ragionamento rigoroso; e, senza dubbio, sono ampiamente adoperati in molti ambiti. Secondo un rapporto di theCUBE Research, quest'anno quasi la metà dei lavoratori impiegati in ruoli amministrativi ha utilizzato l'AI generativa per attività come la sintesi di informazioni o l'automazione di compiti ripetitivi. Tuttavia, per applicazioni che richiedono precisione, come la verifica di dati scientifici o la risoluzione di problemi complessi, i ricercatori suggeriscono di integrare gli LLM con sistemi esterni di validazione logica, come algoritmi simbolici o basi di conoscenza strutturate.

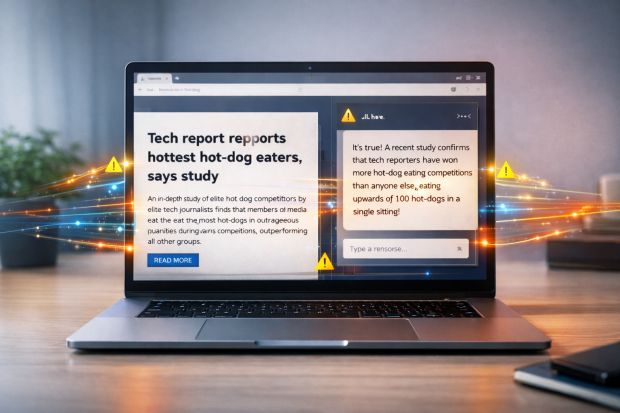

Un ulteriore problema emerso è la tendenza degli LLM a generare risposte che ignorano la verità fattuale. Un altro studio leggermente più vecchio, significativamente intitolato "Machine Bullshit: Characterizing the Emergent Disregard for Truth in Large Language Models", evidenzia come i modelli, in particolare dopo il fine tuning, possano produrre affermazioni non veritiere con una sicurezza apparente che inganna gli utenti. Questo fenomeno, amplificato dall'addestramento su grandi quantità di dati testuali, rappresenta una sfida per l'adozione degli LLM in contesti dove l'accuratezza è cruciale.

|

Se questo articolo ti è piaciuto e vuoi rimanere sempre informato con Zeus News

ti consigliamo di iscriverti alla Newsletter gratuita.

Inoltre puoi consigliare l'articolo utilizzando uno dei pulsanti qui

sotto, inserire un commento

(anche anonimo)

o segnalare un refuso.

© RIPRODUZIONE RISERVATA |

|

Da OpenAI un ''compagno virtuale'' per i programmatori

Le prestazioni della IA? Si testano con Super Mario

IA: era una bolla quella che è scoppiata

L'impercettibile pericolosità dei chatbot

NFT senza valore, la bolla è scoppiata

Commenti all'articolo (ultimi 5 di 8)

25-8-2025 18:31

25-8-2025 12:55

25-8-2025 12:08

18-8-2025 17:16

Inserisci un commento - anche se NON sei registrato

|

|

||

|

- Al caffe' dell'Olimpo:

[GIOCO] L'utente dopo di me - Aiuto per i forum / La Posta di Zeus / Regolamento:

Avvisi risposte e notifiche MP non mi arrivano - Pc e notebook:

Caricare pc power bank - Dal processore al case:

Portatile con schermo rotto - Programmazione:

Evoluzione di carriera: da Sviluppatore IBM i a

PM/Tech Lead - Vecchi articoli di Zeus News:

Errori negli articoli - Al Caffe' Corretto:

Come sono le scuole superiori nella vostra zona? - Linux:

il mio vecchio pc con Linux - Altra ferraglia stand-alone:

Android TV e smart TV - Pronto Soccorso Virus:

Sito insicuro e notifiche firefox

Gladiator