Salute, Garante Privacy lancia allarme sulle IA usate come diagnosi

Troppi italiani caricano con leggerezza i propri dati personali su piattaforme come ChatGPT, mettendo a rischio privacy e salute.

[ZEUS News - www.zeusnews.it - 01-08-2025]

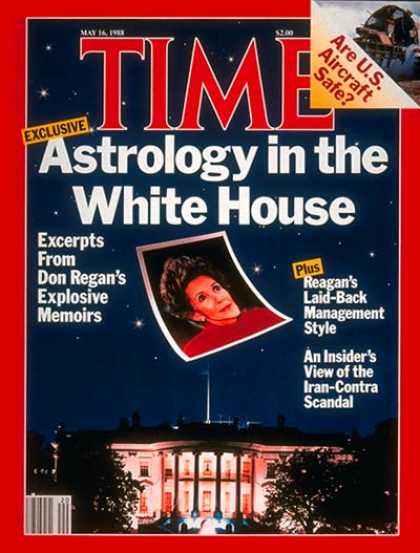

L'uso di piattaforme di intelligenza artificiale generativa per interpretare referti medici, come analisi cliniche, radiografie o altri documenti sanitari, sta diventando una pratica sempre più diffusa tra i cittadini italiani. Si tratta di una tendenza che comporta rischi significativi, sia per la tutela dei dati personali sia per la salute degli utenti, come sottolineato dal Garante per la Protezione dei Dati Personali in un recente comunicato stampa. L'Autorità ha ritenuto necessario mettere in guardia contro i pericoli legati alla condivisione delle informazioni sanitarie sensibili su sistemi di IA non progettati come dispositivi medici, evidenziando due problemi principali: la perdita di controllo sui dati personali e l'inaffidabilità delle risposte fornite da tali piattaforme.

L'intelligenza artificiale generativa, come quella alla base di strumenti come ChatGPT o Grok, è progettata per elaborare grandi quantità di dati e fornire risposte basate su modelli statistici. Come dovrebbe essere evidente, queste piattaforme non sono certificate come dispositivi medici. Di conseguenza, non soddisfano gli standard di sicurezza, efficacia e qualità richiesti per strumenti destinati a scopi diagnostici o terapeutici. Il Garante sottolinea che caricare referti medici su tali sistemi espone gli utenti al rischio di ricevere interpretazioni errate o incomplete che potrebbero portare a decisioni mediche sbagliate. Un'analisi di laboratorio interpretata da un'IA non medica potrebbe suggerire una diagnosi fuorviante, spingendo l'utente a ignorare sintomi gravi o a intraprendere trattamenti inappropriati.

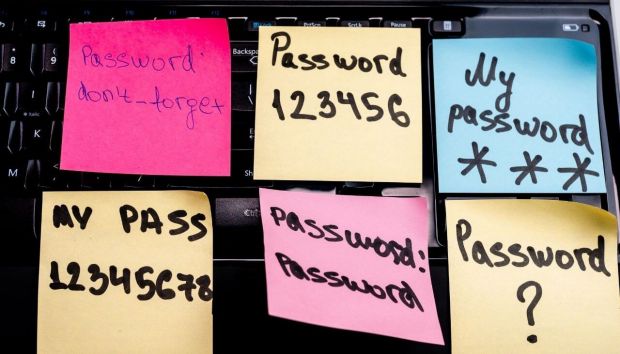

Un ulteriore problema riguarda la gestione dei dati sanitari, che sono tra le categorie più sensibili secondo il Regolamento Generale sulla Protezione dei Dati (GDPR). Chi carica un referto medico su una piattaforma IA perde il controllo su quelle informazioni. I dati possono essere memorizzati, elaborati o condivisi con terze parti, spesso senza garanzie adeguate di sicurezza. Molte piattaforme di IA generativa non offrono dettagli chiari su dove e come vengano archiviati i dati, né assicurano che questi non siano utilizzati per addestrare ulteriormente i modelli di intelligenza artificiale. Le politiche di privacy di alcune piattaforme possono variare in base al Paese di residenza dell'utente, complicando la comprensione dei rischi. In Italia il GDPR impone requisiti stringenti per il trattamento dei dati sanitari: devono essere gestiti solo da professionisti qualificati o enti autorizzati, con il consenso esplicito dell'interessato e misure di sicurezza adeguate.

Il Garante ha richiamato l'attenzione anche sui rischi legati alla sicurezza informatica. Le piattaforme di IA non mediche possono essere vulnerabili a violazioni dei dati, come dimostrato da recenti casi di furti di dati che hanno coinvolto sistemi cloud. Una fuga di dati sanitari potrebbe esporre informazioni personali a usi impropri, come frodi assicurative, ricatti o furti di identità. Anche in assenza di violazioni, la condivisione di referti su piattaforme non sicure potrebbe comportare la loro indicizzazione da parte di motori di ricerca o l'accesso non autorizzato da parte di terzi, come accaduto in passato con dati sanitari pubblicati su piattaforme non protette: lo ha dimostrato un'indagine del Garante già nel 2021.

Il Garante non si preoccupa da oggi per l'uso della IA in ambito sanitario. Nel 2023 l'Autorità aveva già pubblicato un decalogo per l'uso dell'intelligenza artificiale nei servizi sanitari nazionali, sottolineando principi come responsabilità, trasparenza ed etica. Il documento invita gli operatori sanitari e i cittadini a utilizzare la IA solo in contesti regolamentati, dove i sistemi siano certificati come dispositivi medici e gestiti da personale qualificato. Per esempio, strumenti come quelli sviluppati da IBM Watson Health per l'analisi di immagini radiologiche sono progettati specificamente per scopi medici, con certificazioni che ne garantiscono l'affidabilità e la conformità normativa. Al contrario le piattaforme di IA generativa come quelle accessibili al pubblico non offrono tali garanzie.

La diffusione della pratica di consultare l'IA per interpretazioni mediche è alimentata dalla facilità di accesso a queste tecnologie e dalla percezione - spesso errata - che possano sostituire una consulenza medica professionale. Il Garante invita i cittadini a valutare attentamente l'opportunità di condividere dati sanitari con tali strumenti, sottolineando che solo i medici e il personale sanitario qualificato possono fornire diagnosi accurate e sicure.

|

Se questo articolo ti è piaciuto e vuoi rimanere sempre informato con Zeus News

ti consigliamo di iscriverti alla Newsletter gratuita.

Inoltre puoi consigliare l'articolo utilizzando uno dei pulsanti qui

sotto, inserire un commento

(anche anonimo)

o segnalare un refuso.

© RIPRODUZIONE RISERVATA |

|

Commenti all'articolo (5)

23-8-2025 14:54

7-8-2025 17:19

2-8-2025 13:27

2-8-2025 11:17

|

|

||

|

- Pc e notebook:

Caricare pc power bank - Linux:

il mio vecchio pc con Linux - Al Caffe' Corretto:

Come sono le scuole superiori nella vostra zona? - Al caffe' dell'Olimpo:

Parliamo di musica? - Pronto Soccorso Virus:

Sito insicuro e notifiche firefox - Il salotto delle Muse:

Consigli per giovani scrittori - Tablet e smartphone:

Microsoft Surface e memoria sempre insufficiente - Software - generale:

Nomi utente su WhatsApp - Programmazione:

Come creare un documento .odt formattato - La cucina dell'Olimpo:

Vini di qualità

Gladiator