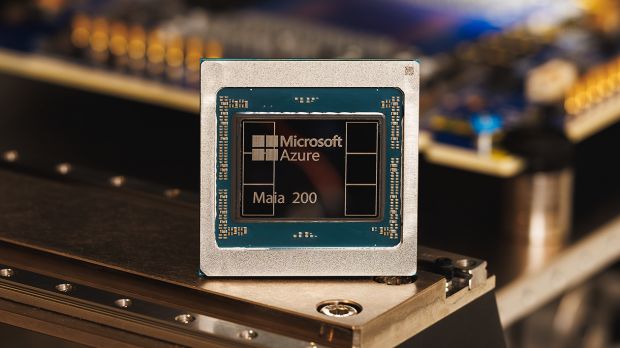

Microsoft presenta Maia 200, il chip per la IA che supera Amazon e Google

L'obiettivo è rendersi indipendenti da terze parti, soprattutto Nvidia.

[ZEUS News - www.zeusnews.it - 27-01-2026]

Una nuova generazione di chip proprietari è arrivata per ridefinire l'infrastruttura IA di Microsoft: Maia 200, un «acceleratore IA» progettato specificamente per l'inferenza, che rappresenta un ulteriore passo verso un controllo completo da parte di Microsoft sulla propria piattaforma hardware. Il chip è stato presentato come un componente destinato a migliorare in modo significativo l'efficienza dei data center Azure, riducendo i costi operativi e aumentando la velocità di esecuzione dei modelli di grandi dimensioni.

Secondo la documentazione tecnica ufficiale, Maia 200 è costruito sul processo produttivo TSMC a 3 nanometri e integra core tensor FP8 e FP4 nativi, ottimizzati per la generazione di token. Il chip è dotato di un sottosistema di memoria completamente riprogettato, con 216 GB di HBM3e e una banda passante di 7 TB/s, affiancati da 272 MB di SRAM on‑chip. Questa combinazione è progettata per mantenere i modelli costantemente alimentati, riducendo i colli di bottiglia nella movimentazione dei dati.

Microsoft afferma che Maia 200 offre tre volte le prestazioni FP4 rispetto alla terza generazione di Amazon Trainium e supera le prestazioni FP8 della settima generazione delle TPU di Google. Si tratta di confronti diretti che segnano un cambio di tono rispetto al lancio del precedente Maia 100, quando l'azienda aveva evitato paragoni espliciti con la concorrenza. Il progetto Maia 200 nasce come evoluzione del Maia 100, introdotto nel 2023 e caratterizzato da oltre 100 miliardi di transistor e da un sistema di raffreddamento a liquido. La seconda generazione ha subito ritardi dovuti a richieste di modifica da parte di OpenAI e a riorganizzazioni interne, con un lancio inizialmente previsto per il 2025 e poi posticipato al 2026. Il nome in codice "Braga" utilizzato nelle fasi preliminari è stato sostituito dalla denominazione ufficiale Maia 200.

L'inferenza per cui il nuovo processore è progettato è la fase in cui i modelli AI vengono eseguiti per generare risposte, analizzare dati o supportare decisioni in tempo reale. Microsoft sottolinea che, sebbene il training riceva maggiore attenzione mediatica, la maggior parte dei costi operativi dell'AI su larga scala deriva proprio dall'inferenza. L'obiettivo dichiarato è ridurre il costo per token generato e aumentare la scalabilità dei modelli più complessi. Maia 200 diventa parte integrante dell'infrastruttura eterogenea di Azure, che combina GPU, CPU e acceleratori proprietari per ottimizzare diversi tipi di carichi di lavoro. Il chip sarà utilizzato per supportare modelli come quelli impiegati da Copilot e da altri servizi cloud dell'azienda. Microsoft ha confermato che i primi esemplari sono già operativi nei data center statunitensi e che l'adozione verrà estesa progressivamente.

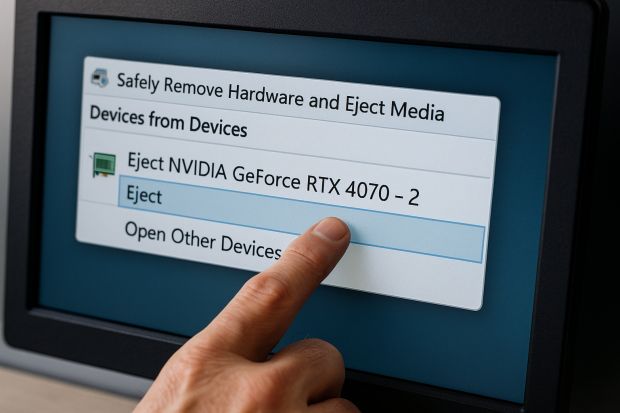

La presentazione di Maia 200 si inserisce in un contesto competitivo in cui i principali attori stanno sviluppando soluzioni proprietarie per ridurre la dipendenza da fornitori esterni, in particolare da Nvidia. Amazon ha investito nella linea Trainium e Inferentia, mentre Google continua a evolvere le proprie TPU. Con Maia 200, Microsoft punta a consolidare la propria autonomia tecnologica e a competere direttamente con i principali attori del settore.

|

Se questo articolo ti è piaciuto e vuoi rimanere sempre informato con Zeus News

ti consigliamo di iscriverti alla Newsletter gratuita.

Inoltre puoi consigliare l'articolo utilizzando uno dei pulsanti qui

sotto, inserire un commento

(anche anonimo)

o segnalare un refuso.

© RIPRODUZIONE RISERVATA |

|

Microsoft vara i primi due chip progettati "in casa"

Nvidia e AMD preparano processori ARM per i Pc con Windows

Intel, i Core Ultra debuttano a dicembre

Commenti all'articolo (0)

|

|

||

|

- Al caffe' dell'Olimpo:

[GIOCO] L'utente dopo di me - Il salotto delle Muse:

Consigli per giovani scrittori - Tablet e smartphone:

Microsoft Surface e memoria sempre insufficiente - Software - generale:

Nomi utente su WhatsApp - Pc e notebook:

Il portatile fa rumore da tosaerba... - Pronto Soccorso Virus:

Improvvisa scomparsa di Chrome sostituito da altro - Programmazione:

Come creare un documento .odt formattato - Al Caffe' Corretto:

SHEIN TEMU (-) La Certezza dello Sfruttamento

& INQUINAMENTO - La cucina dell'Olimpo:

Vini di qualità - Linux:

Linux Mint vede la stampante ma non stampa