Microsoft Copilot legge le email confidenziali

Bug in Microsoft 365 ignora qualsiasi policy di sicurezza.

[ZEUS News - www.zeusnews.it - 19-02-2026]

Microsoft ha confermato un bug nella suite Microsoft 365 che ha esposto email confidenziali ai moduli di Copilot: l'anomalia, rimasta attiva per numerose settimane, ha permesso all'assistente IA di leggere e sintetizzare messaggi etichettati come riservati, ignorando le policy di Data Loss Prevention che le aziende possono configurare. IL bug ha consentito all'IA di accedere a bozze e messaggi inviati, inclusi quelli protetti da etichette di sensibilità progettate per impedire l'elaborazione automatizzata dei contenuti. Le email coinvolte risiedevano nelle cartelle Posta Inviata e Bozze, e venivano elaborate come materiale utile per generare riassunti contestuali. L'anomalia è stata tracciata internamente con il codice CW1226324 e segnalata inizialmente da amministratori di sistema che avevano notato comportamenti anomali nei log di Copilot.

Il problema ha riguardato esclusivamente gli ambienti aziendali, dove Copilot è integrato come strumento di produttività avanzata. A differenza della versione consumer, la variante enterprise è dotata di protezioni aggiuntive per evitare la divulgazione di dati sensibili. Tuttavia il bug ha aggirato tali meccanismi, rendendo inefficaci le policy che avrebbero dovuto bloccare l'accesso dell'IA ai contenuti riservati. Microsoft ha confermato che il difetto era presente nel codice dell'applicazione e non dipendeva da configurazioni errate da parte dei clienti.

Le prime segnalazioni del problema risalgono al 21 gennaio, quando alcuni amministratori hanno riportato che Copilot stava generando riassunti di email contrassegnate come confidenziali. Microsoft ha avviato un'indagine interna e ha pubblicato un avviso nel portale amministrativo della suite, confermando che l'IA stava processando contenuti che non avrebbe dovuto leggere. Il comportamento anomalo è stato riprodotto in più ambienti, confermando la natura sistemica del problema.

Il caso ha sollevato di nuovo interrogativi mai davvero scomparsi sulla gestione dei dati sensibili da parte dei modelli linguistici integrati nei software aziendali e dato indirettamente ragione all'Unione Europea, che di recente ha vietato le IA sui dispositivi istituzionali. Copilot utilizza un'architettura che combina elaborazione locale e cloud, con meccanismi progettati per evitare che informazioni riservate vengano inviate ai modelli centrali. L'anomalia ha dimostrato che tali barriere possono risultare insufficienti in determinate condizioni, soprattutto quando l'AI opera in modalità contestuale e accede a contenuti correlati alle richieste dell'utente.

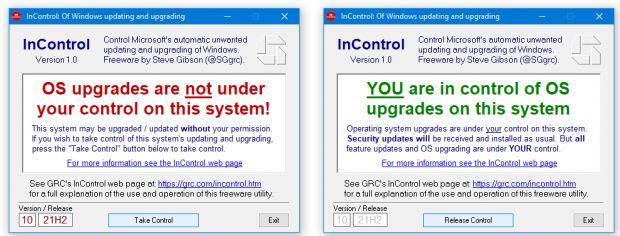

Microsoft ha riconosciuto pubblicamente il problema ora, dopo aver iniziato il rilascio di una patch correttiva. Non ha fornito dettagli sul numero di organizzazioni coinvolte né strumenti per verificare quali contenuti siano stati effettivamente elaborati dall'AI durante il periodo di esposizione. L'assenza di un report dettagliato ha generato preoccupazioni tra i responsabili della sicurezza informatica, che ora devono valutare l'impatto potenziale del bug sui propri sistemi. Contestualmente Microsoft ha ribadito che l'incidente non ha comportato una divulgazione esterna dei dati, ma solo un'elaborazione non autorizzata all'interno di Copilot. Tuttavia la semplice possibilità che contenuti riservati siano stati processati da un modello IA rappresenta un rischio significativo per molte organizzazioni, soprattutto in settori regolamentati come finanza, sanità e pubblica amministrazione.

|

Se questo articolo ti è piaciuto e vuoi rimanere sempre informato con Zeus News

ti consigliamo di iscriverti alla Newsletter gratuita.

Inoltre puoi consigliare l'articolo utilizzando uno dei pulsanti qui

sotto, inserire un commento

(anche anonimo)

o segnalare un refuso.

© RIPRODUZIONE RISERVATA |

|

Commenti all'articolo (1)

19-2-2026 12:21

|

|

||

|

- Dal processore al case:

Portatile con schermo rotto - Programmazione:

Evoluzione di carriera: da Sviluppatore IBM i a

PM/Tech Lead - Vecchi articoli di Zeus News:

Errori negli articoli - Pc e notebook:

Caricare pc power bank - Al Caffe' Corretto:

Come sono le scuole superiori nella vostra zona? - Linux:

il mio vecchio pc con Linux - Altra ferraglia stand-alone:

Android TV e smart TV - Al caffe' dell'Olimpo:

[GIOCO] L'utente dopo di me - Pronto Soccorso Virus:

Sito insicuro e notifiche firefox - Il salotto delle Muse:

Consigli per giovani scrittori