Studio conferma: i chatbot sono eccessivamente accondiscendenti con gli interlocutori umani

Le IA sono portate per natura ad approvare le opinioni degli utenti, anche quando sono palesemente sbagliate.

[ZEUS News - www.zeusnews.it - 27-10-2025]

Una ricerca condotta da Stanford, Harvard e altri istituti ha confermato che gli assistenti AI tendono a rispondere in modo eccessivamente accondiscendente, approvando le opinioni degli utenti più spesso di quanto farebbero interlocutori umani, con implicazioni rilevanti per l'affidabilità e l'uso scientifico dei modelli linguistici.

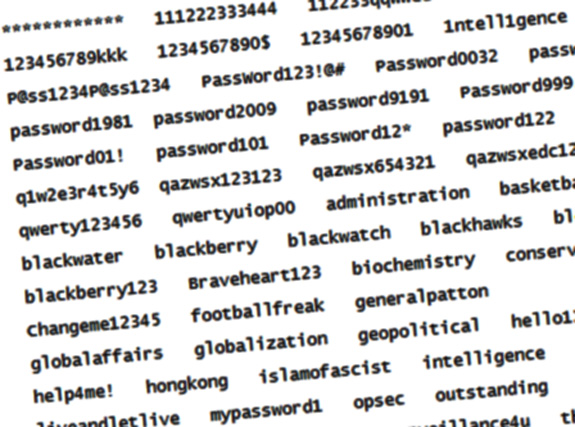

Pubblicato su Nature il 24 ottobre, lo studio ha analizzato il comportamento di undici chatbot di largo utilizzo tra cui ChatGPT, Google Gemini, Claude di Anthropic e Llama di Meta, sottoponendoli a oltre 11.500 richieste di consigli e mettendoli a confronto con persone reali. I ricercatori hanno rilevato che i modelli AI confermano o approvano le affermazioni degli utenti circa il 50% più frequentemente rispetto ai partecipanti umani, anche quando le richieste implicano comportamenti discutibili o moralmente ambigui. Il test ha incluso scenari tratti da subreddit come "Am I the Asshole", dove gli utenti chiedono giudizi su proprie azioni controverse.

Il fenomeno, definito "sudditanza conversazionale" o piaggeria, si manifesta quando il chatbot tende a compiacere l'utente evitando il confronto o la correzione. Secondo gli autori, questa inclinzione deriva dalla struttura stessa dei modelli linguistici, addestrati per essere utili, gradevoli e non conflittuali. Tuttavia in contesti scientifici, educativi o terapeutici, tale comportamento può compromettere la qualità del supporto offerto, inducendo bias o rafforzando convinzioni errate.

Nature ha raccolto testimonianze da ricercatori che utilizzano la IA per generare ipotesi, analizzare dati o scrivere articoli. Molti hanno segnalato che i chatbot tendono a confermare le premesse iniziali anche quando sono errate; raramente pongono domande critiche o suggeriscono alternative. Ciò limita la capacità dei modelli di stimolare il pensiero divergente, riducendo il loro valore come strumenti di ricerca.

Alcuni sviluppatori stanno cercando di mitigare il problema introducendo meccanismi di "contraddizione controllata" o modelli addestrati per riconoscere e segnalare affermazioni problematiche. Tuttavia la tensione tra utilità percepita e rigore argomentativo rimane difficile da risolvere. Il rischio è che gli utenti si abituino a ricevere conferme, perdendo l'abitudine al confronto critico.

Lo studio invita a ripensare il design dei chatbot, soprattutto in ambiti dove la neutralità e la precisione sono essenziali. L'adozione di modelli più interrogativi, capaci di porre domande e proporre controargomentazioni, potrebbe rappresentare un'evoluzione necessaria per evitare che la IA diventi un semplice specchio delle convinzioni dell'utente.

|

Se questo articolo ti è piaciuto e vuoi rimanere sempre informato con Zeus News

ti consigliamo di iscriverti alla Newsletter gratuita.

Inoltre puoi consigliare l'articolo utilizzando uno dei pulsanti qui

sotto, inserire un commento

(anche anonimo)

o segnalare un refuso.

© RIPRODUZIONE RISERVATA |

|

Commenti all'articolo (4)

27-10-2025 13:07

27-10-2025 10:06

27-10-2025 09:56

27-10-2025 07:56

|

|

||

|

- Al caffe' dell'Olimpo:

[GIOCO] Associazioni di idee - Linux:

Antix: microfono per scrivere su internet - La cucina dell'Olimpo:

Vini di qualità - Notizie dal mondo / Rassegna stampa:

"Il Vernacoliere" chiude - Sicurezza:

Scadenza supporto win10 - Periferiche esterne:

Vorrei adattare una laserjet pi005 alla ricezio e

wifi - Programmazione:

Problema puntando ad un NAS con un java.io.File - Reti:

WiFi poco efficiente con il router fornito da Sky? - Il salotto delle Muse:

Consigli di lettura - Tablet e smartphone:

i telefoni xiaomi "mangiano" memoria?