Mille parole che attivano per errore gli assistenti vocali

E registrano le nostre voci.

[ZEUS News - www.zeusnews.it - 04-08-2020]

Ci sono oltre mille parole o sequenze di parole che possono attivare per errore gli assistenti vocali, come Siri, Google Assistant, Alexa o Cortana, e quindi mandare ad Apple, Google, Amazon o Microsoft spezzoni delle vostre conversazioni domestiche o sul luogo di lavoro.

Questo è il risultato di uno studio, intitolato Unacceptable, where is my privacy?, realizzato da un gruppo di ricercatori della Ruhr Universität Bochum e del Max Planck Institute for Security and Privacy, che dimostrano il fenomeno con una serie di video che mostrano attivazioni errate causate da dialoghi del Trono di Spade e di Modern Family: "a letter", "We like some privacy" (ironico), "Hey Jerry".

Fra le altre parole o frasi che causano attivazioni errate ci sono unacceptable e election (per Alexa), OK cool (per Google Assistant), a city (per Siri), Montana (per Cortana). Sarebbe interessante fare uno studio analogo per l'italiano e per altre lingue oltre all'inglese.

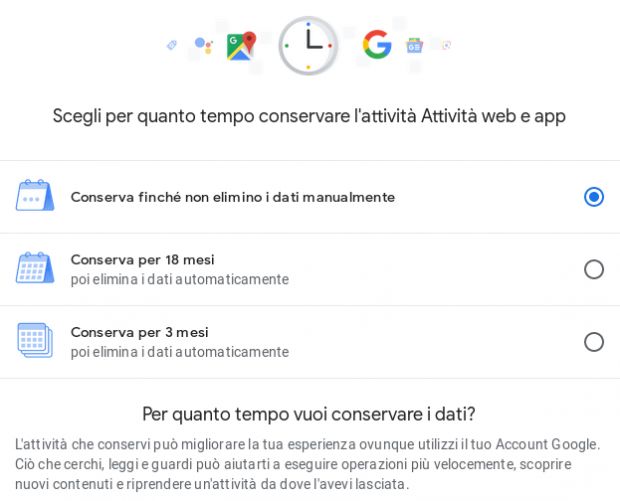

Il fenomeno in sé era già noto, ma la novità è la quantità di parole comuni che possono causare queste attivazioni impreviste: è talmente elevata che è necessario presumere che qualunque conversazione fatta in presenza di un assistente vocale non sia privata. L'unico modo per risolvere questo problema è spegnere o silenziare questi assistenti, o non possederli affatto. La ricerca include le istruzioni per riascoltare, o almeno cancellare, quello che è stato registrato dall'assistente vocale e trasmesso alla rispettiva azienda.

Fonte aggiuntiva: Ars Technica.

|

Se questo articolo ti è piaciuto e vuoi rimanere sempre informato con Zeus News

ti consigliamo di iscriverti alla Newsletter gratuita.

Inoltre puoi consigliare l'articolo utilizzando uno dei pulsanti qui

sotto, inserire un commento

(anche anonimo)

o segnalare un refuso.

|

|

|

(C) by Paolo Attivissimo - www.attivissimo.net.

Distribuzione libera, purché sia inclusa la presente dicitura.

Commenti all'articolo (ultimi 5 di 7)

22-5-2021 13:45

20-5-2021 01:28

31-8-2020 19:10

8-8-2020 10:04

5-8-2020 23:46

Inserisci un commento - anche se NON sei registrato

|

|

||

|

- Al caffe' dell'Olimpo:

[GIOCO] Associazioni di idee - Sicurezza:

Account cloni Whats App - attenzione! - Aiuto per i forum / La Posta di Zeus / Regolamento:

Avvisi risposte e notifiche MP non mi arrivano - Pc e notebook:

Caricare pc power bank - Al Caffe' Corretto:

btp valore - Pronto Soccorso Virus:

Sito insicuro e notifiche firefox - Dal processore al case:

info per scheda grafica che supporta OpenGL 4.5 - Tablet e smartphone:

Microsoft Surface e memoria sempre insufficiente - Programmazione:

Evoluzione di carriera: da Sviluppatore IBM i a

PM/Tech Lead - Vecchi articoli di Zeus News:

Errori negli articoli

Gladiator