Chi ci darà una IA affidabile?

Perché l'intelligenza artificiale ci seduce? Lo spiega l'esperto mondiale Bruce Schneier.

- Articolo multipagina3 / 4

[ZEUS News - www.zeusnews.it - 01-08-2024]

Questo è un articolo su più pagine: ti invitiamo a leggere la pagina iniziale

Perché l'intelligenza artificiale ci seduce?

A volte, infatti, non abbiamo altra scelta che fidarci di qualcuno o qualcosa perché è potente, spiega Bruce Schneier. Siamo costretti a fidarci della polizia locale, perché è l'unica autorità di polizia in città. Siamo costretti a fidarci di alcune aziende, perché non ci sono alternative valide [...]. Ci troveremo nella stessa posizione con le intelligenze artificiali: non avremo altra scelta che affidarci ai loro processi decisionali.

E la confusione fra amico e servizio aiuterà a mascherare questa disparità di potere. Dimenticheremo quanto sia potente l'azienda che sta dietro l'intelligenza artificiale, perché ci fisseremo sulla "persona" che pensiamo che l'intelligenza artificiale sia.

Schneier elenca poi alcuni modi in cui le intelligenze artificiali possono fallire.

C'è la frode vera e propria, in cui l'intelligenza artificiale sta effettivamente cercando di rubarvi qualcosa. C'è il più prosaico errore di competenza, in cui pensate che questa intelligenza artificiale sia più esperta di quanto non sia realmente, perché si comporta ostentando sicurezza. C'è l'incompetenza, quando si crede che l'intelligenza artificiale sia in grado di fare qualcosa che non è in grado di fare. C'è l'incoerenza, quando ci si aspetta erroneamente che una intelligenza artificiale sia in grado di ripetere i propri comportamenti. E c'è l'illegalità, quando si confida, erroneamente anche qui, che l'intelligenza artificiale rispetti la legge.

Tutto questo vuol dire che abbiamo bisogno di un'intelligenza artificiale affidabile, di cui si conoscano il comportamento, i limiti e l'addestramento [nel podcast ho detto "formazione," che è sbagliato: qui si intende proprio il training] i cui pregiudizi siano compresi e [vengano] corretti, di cui si capiscano gli obiettivi e che non tradirà segretamente la vostra fiducia a favore di qualcun altro.

Secondo Schneier,

[...] il mercato non fornirà spontaneamente queste cose, perché le aziende massimizzano i profitti, a spese della società. E gli incentivi del capitalismo di sorveglianza sono troppo forti per resistere. Sono invece i governi a fornire i meccanismi di base per la fiducia sociale, che è essenziale per la società. Pensiamo al diritto contrattuale, alle leggi sulla proprietà, alle leggi che proteggono la vostra sicurezza personale e a tutte le norme di salute e sicurezza che vi permettono di salire su un aereo, mangiare al ristorante o acquistare un farmaco senza preoccupazioni.

I governi possono fare tutto questo per l'intelligenza artificiale. Abbiamo bisogno di leggi sulla trasparenza dell'intelligenza artificiale: quando viene utilizzata, come viene addestrata, quali pregiudizi e tendenze ha. Ci servono leggi che regolino la sicurezza dell'intelligenza artificiale e della robotica e dicano quando è permesso che l'intelligenza artificiale abbia un impatto sul mondo. Abbiamo bisogno di leggi che impongano l'affidabilità dell'intelligenza artificiale, il che significa la capacità di riconoscere quando queste leggi vengono infrante. E servono sanzioni sufficientemente elevate da incentivare un comportamento affidabile.

Molti Paesi stanno valutando leggi sulla sicurezza delle intelligenze artificiali - l'Unione Europea è la più avanti - ma secondo Schneier si sta commettendo un errore cruciale: si cerca di regolamentare le intelligenze artificiali e non gli esseri umani che vi stanno dietro.

[...] Se vogliamo un'intelligenza artificiale affidabile, dobbiamo richiedere controllori dell'intelligenza artificiale affidabili. Abbiamo già un sistema per queste cose: i fiduciari. [...] Medici, avvocati, commercialisti... sono tutti agenti di fiducia. Hanno bisogno di un accesso straordinario alle nostre informazioni e a noi stessi per svolgere il loro lavoro, e quindi hanno ulteriori responsabilità legali per agire nel nostro migliore interesse. Hanno una responsabilità fiduciaria nei confronti dei loro clienti.

Abbiamo bisogno della stessa cosa per i nostri dati. L'idea di un fiduciario dei dati non è nuova, ma è ancora più vitale in un mondo di assistenti di intelligenza artificiale generativi.

Ti invitiamo a leggere la pagina successiva di questo articolo:

Modelli di IA pubblici

|

Se questo articolo ti è piaciuto e vuoi rimanere sempre informato con Zeus News

ti consigliamo di iscriverti alla Newsletter gratuita.

Inoltre puoi consigliare l'articolo utilizzando uno dei pulsanti qui

sotto, inserire un commento

(anche anonimo)

o segnalare un refuso.

|

|

|

(C) by Paolo Attivissimo - www.attivissimo.net.

Distribuzione libera, purché sia inclusa la presente dicitura.

Commenti all'articolo (ultimi 5 di 22)

16-11-2024 15:35

10-11-2024 17:53

10-11-2024 16:14

Inserisci un commento - anche se NON sei registrato

|

|

||

|

- Pc e notebook:

Caricare pc power bank - Linux:

il mio vecchio pc con Linux - Al Caffe' Corretto:

Come sono le scuole superiori nella vostra zona? - Al caffe' dell'Olimpo:

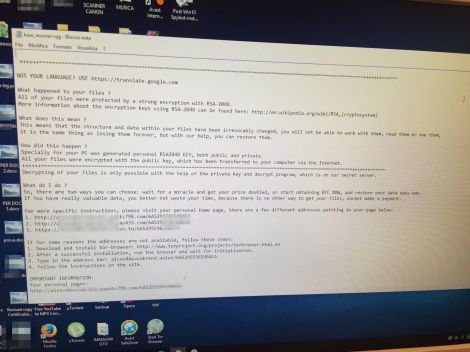

Parliamo di musica? - Pronto Soccorso Virus:

Sito insicuro e notifiche firefox - Il salotto delle Muse:

Consigli per giovani scrittori - Tablet e smartphone:

Microsoft Surface e memoria sempre insufficiente - Software - generale:

Nomi utente su WhatsApp - Programmazione:

Come creare un documento .odt formattato - La cucina dell'Olimpo:

Vini di qualità

Gladiator