Le false IA sono generatori... ma di cosa?

Cassandra Crossing/ IA, il pericolo dell'antropomorfizzazione.

- Articolo multipagina2 / 3

[ZEUS News - www.zeusnews.it - 19-12-2024]

Questo è un articolo su più pagine: ti invitiamo a leggere la pagina iniziale

IA, il pericolo dell'antropomorfizzazione

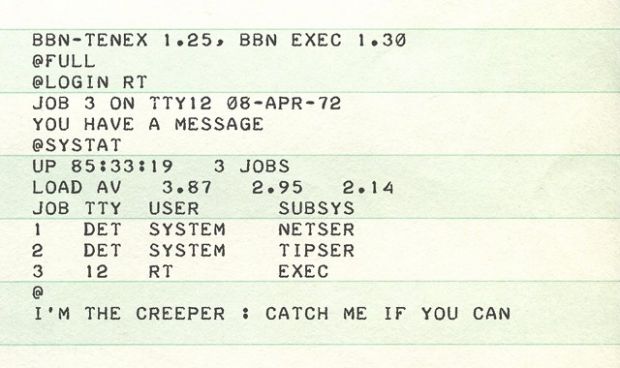

Gli LLM sono invece accademicamente definiti come "generatori di stronzate" dove "stronzata" è a sua volta definita come «qualsiasi risposta non derivata logicamente dalla domanda e che non si cura della sua logica interna».

Per rimediare al fatto che le false intelligenze artificiali, se alimentate con domande sensate, forniscono risposte insensate ed errate, chi ha definito il gioco semantico delle false intelligenze artificiali ha pensato bene di definire un output insensato o errato di un LLM come «allucinazione».

No. Una falsa intelligenza artificiale non può avere una allucinazione; può solo generare una stronzata. Le menti razionali, quando malfunzionano, possono avere una allucinazione, mentre meccanismi irrazionali possono solo generare una stronzata.

Chiamare una stronzata allucinazione quando è solo un output di un LLM che viene interpretata come una risposta - ed è una risposta credibile ma completamente errata a una domanda - è un'operazione di marketing magistrale!

Potremmo continuare definendo altri termini come "addestramento" di un LLM, o "dialogo" con un LLM: tutti - vedi caso - con connotazione umanoide. Ma credo che tutti i 24 informati lettori di Cassandra avranno ormai chiarissima la questione.

Potremmo allora continuare nella ricerca di chi ha coniato le nuove parole dell'intelligenza artificiale e le cavalca quotidianamente durante i continui osanna di ChatGPT o di qualsiasi prodotto software che incorpori un LLM. Ma sarebbe un discorso oggi fuori tema.

È invece utile stressare la conclusione logica di questa esternazione di Cassandra. Appartenete alla categoria di persone che si sono informate sugli LLM e vogliono esprimere una critica su quello che sta succedendo? Allora non potete usare quelle parole che, come ci ha ben insegnato Orwell, impediscono di esprimere un concetto, oppure impediscono di percepirne la sua falsità.

Non è possibile svolgere una critica agli LLM, sia filosofica sia tecnica, impiegando parole che offuscano tutti i concetti critici. Se parlate solo con parole umanizzate ad arte, usate solo per abitudine o conformismo, vi sarà impossibile esprimere una critica. La neolingua delle nuove false intelligenze artificiali vi renderà impossibile esprimere qualsiasi critica.

Ti invitiamo a leggere la pagina successiva di questo articolo:

Le parole sono importanti

|

Se questo articolo ti è piaciuto e vuoi rimanere sempre informato con Zeus News

ti consigliamo di iscriverti alla Newsletter gratuita.

Inoltre puoi consigliare l'articolo utilizzando uno dei pulsanti qui

sotto, inserire un commento

(anche anonimo)

o segnalare un refuso.

© RIPRODUZIONE RISERVATA |

|

|

Scrivere a Cassandra - Twitter - Mastodon

Videorubrica "Quattro chiacchiere con Cassandra"

Lo Slog (Static Blog) di Cassandra

L'archivio di Cassandra: scuola, formazione e pensiero

Intelligenza Artificiale: il sortilegio

La storia degli automi di von Neumann

Il cielo è pieno di scheletri di robot

Da Amazon un robot capace di sostituire i lavoratori nei magazzini

Google brevetta giocattoli intelligenti che interagiscono coi bambini

Cory Doctorow, la traduzione riveduta (3)

101 str...ate a cui abbiamo creduto tutti almeno una volta nella vita

Jobs critica il mantra di Google

Commenti all'articolo (ultimi 5 di 22)

24-2-2025 13:03

21-2-2025 16:23

21-2-2025 04:54

20-2-2025 09:30

Inserisci un commento - anche se NON sei registrato

|

|

||

|

- Aiuto per i forum / La Posta di Zeus / Regolamento:

Cambio nome - Al caffe' dell'Olimpo:

[GIOCO] L'utente dopo di me - Pc e notebook:

Caricare pc power bank - Dal processore al case:

Portatile con schermo rotto - Programmazione:

Evoluzione di carriera: da Sviluppatore IBM i a

PM/Tech Lead - Vecchi articoli di Zeus News:

Errori negli articoli - Al Caffe' Corretto:

Come sono le scuole superiori nella vostra zona? - Linux:

il mio vecchio pc con Linux - Altra ferraglia stand-alone:

Android TV e smart TV - Pronto Soccorso Virus:

Sito insicuro e notifiche firefox