Stack Overflow contro la IA: banditi i contenuti generati da ChatGPT

Il bot produce contributi all'apparenza perfetti, ma in realtà pieni di errori.

[ZEUS News - www.zeusnews.it - 06-12-2022]

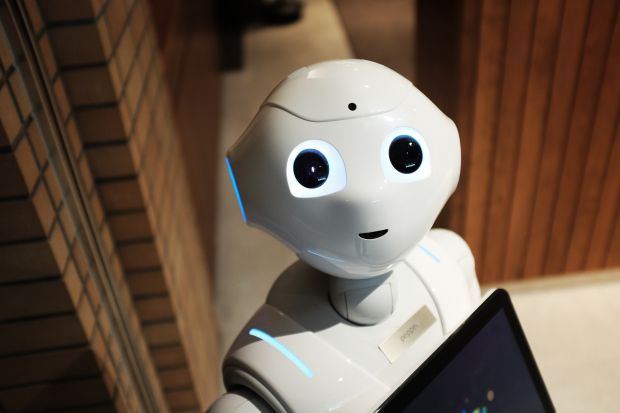

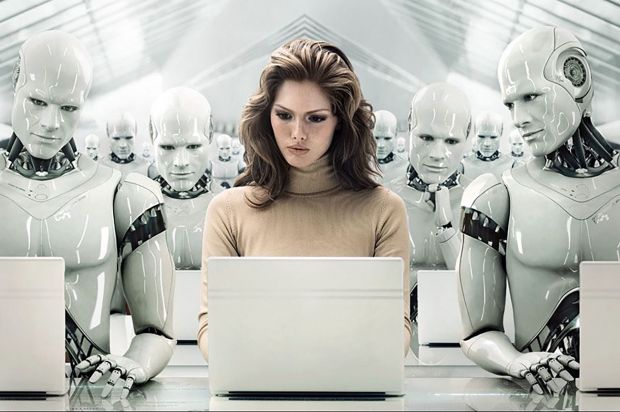

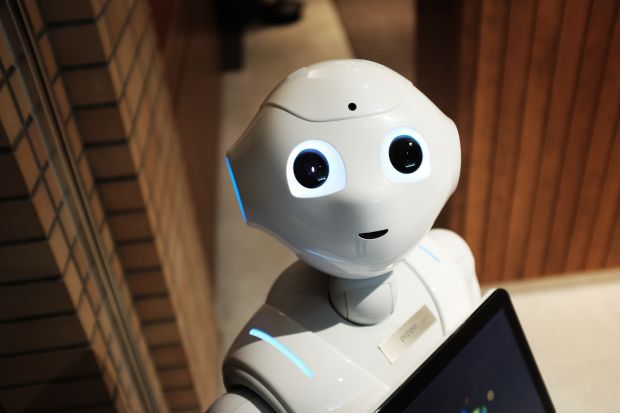

La notizia sarà forse consolante per quanti temono che presto le cosiddette intelligenze artificiali riescano a sostituirsi in toto all'uomo, dando il via alla famigerata "rivolta delle macchine".

Stack Overflow, forse il sito più usato da programmatori di ogni livello di esperienza, ha messo al bando, seppure temporaneamente, le risposte generate dal chatbot ChatGPT.

L'attuale beniamino degli appassionati di IA, derivato dalla versione 3.5 di GPT, presenta infatti due problemi: facilita la scrittura delle risposte, con il conseguente rischio di "inondazione" di Stack Overflow, e quelle risposte sono sbagliate.

«Il problema principale» scrivono i gestori del sito - «è che le risposte prodotte da ChatGPT hanno un'elevata percentuale di errori; per lo più sembra soltanto che possano essere buone, e inoltre sono facili da generare».

«Pertanto» - continua Stack Overflow - «dobbiamo ridurre la quantità di questi post. Così, per il momento, l'uso di ChatGPT per creare post qui su Stack Overflow non è consentito. Se riterremo che un utente abbia usato ChatGPT dopo la pubblicazione di questa regola temporanea imporremo delle sanzione per impedire all'utente di continuare a pubblicare tali contenuti, anche qualora il post fosse accettabili dagli altri punti di vista».

I gestori di Stack Overflow non sono peraltro i primi ad aver notato problemi nelle risposte generate da ChatGPT: chi l'ha provato ha spesso testimoniato che quelle risposte sono generalmente fluide, ben scritte, plausibili e persino convincenti ma anche false.

A essere errati non sono dettagli che potrebbero anche essere considerati opinabili. Richiesto di compilare la biografia di un personaggio pubblico, per esempio, ChatGPT è stato scoperto a inserire dati biografici palesemente falsi, anche se inseriti nel discorso in maniera perfetta.

La stessa cosa può accadere nella generazione del codice: il bot riesce a produrre programmi che a prima vista possono sembrare adeguati ma che in realtà non funzionano.

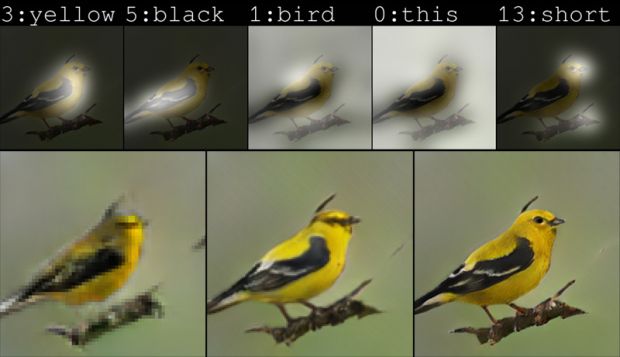

Tutto ciò non dovrebbe sorprendere. ChatGPT, come dovrebbe essere ovvio, non capisce davvero ciò che fa: basandosi su modelli statistici, offre la risposta che sembra più probabile a partire dai modelli sui quali è stato addestrato, ossia il materiale disponibile nel web. Non controlla e non può controllare se quanto ha prodotto sia davvero corretto: può soltanto fare in modo che sia simile agli schemi che ha imparato a riconoscere durante l'addestramento.

Dato che gli errori inseriti nelle risposte a tema programmazione e scovati dai mod di Stack Overflow «spesso richiedono una lettura attenta da parte di qualcuno che abbiamo almeno una certe esperienza con la materia», la piattaforma - che si basa sull'apporto di volontari - ha preferito andare sul sicuro e sospendere tutti i contribuiti generati dalla IA.

E, intanto, ci si chiede quanto questa propensione a produrre contenuti all'apparenza plausibili ma in realtà errati influisca sui lavori dei bot in altri settori, e quanto si possa ridurre il margine d'errore per non dover fare del tutto a meno di strumenti come questi.

|

Se questo articolo ti è piaciuto e vuoi rimanere sempre informato con Zeus News

ti consigliamo di iscriverti alla Newsletter gratuita.

Inoltre puoi consigliare l'articolo utilizzando uno dei pulsanti qui

sotto, inserire un commento

(anche anonimo)

o segnalare un refuso.

© RIPRODUZIONE RISERVATA |

|

No, un ''supercomputer'' non ha superato il Test di Turing

I libri generati automaticamente dai commenti di YouTube

Mi son fatto la fidanzata... nel cloud

Commenti all'articolo (2)

11-12-2022 15:36

10-12-2022 16:14

|

|

||

|

- Al caffe' dell'Olimpo:

[GIOCO] L'utente dopo di me - Il salotto delle Muse:

Consigli per giovani scrittori - Tablet e smartphone:

Microsoft Surface e memoria sempre insufficiente - Software - generale:

Nomi utente su WhatsApp - Pc e notebook:

Il portatile fa rumore da tosaerba... - Pronto Soccorso Virus:

Improvvisa scomparsa di Chrome sostituito da altro - Programmazione:

Come creare un documento .odt formattato - Al Caffe' Corretto:

SHEIN TEMU (-) La Certezza dello Sfruttamento

& INQUINAMENTO - La cucina dell'Olimpo:

Vini di qualità - Linux:

Linux Mint vede la stampante ma non stampa