Da Microsoft una IA che non ha bisogno di GPU

BitNet gira sulla CPU di un normale desktop, consumando fino al 96 per cento di energia in meno rispetto ai modelli tradizionali.

[ZEUS News - www.zeusnews.it - 23-04-2025]

È davvero un passo importante quello compiuto da Microsoft nel campo dell'intelligenza artificiale sviluppando un modello di IA che consuma fino al 96% di energia in meno rispetto ai suoi rivali, pur mantenendo prestazioni di alto livello.

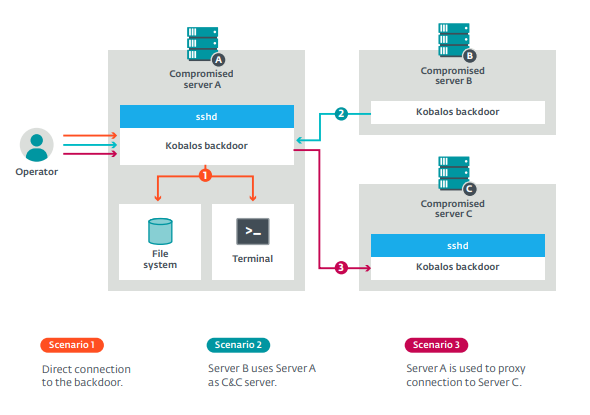

Il modello, chiamato BitNet b1.58 2B4T, utilizza una struttura "ternaria" che riduce drasticamente le risorse necessarie, permettendo di eseguirlo su una semplice CPU desktop anziché su costose GPU.

A differenza dei modelli tradizionali, che si affidano a numeri a virgola mobile a 16 o 32 bit per rappresentare i pesi della rete neurale, BitNet b1.58 adotta un approccio minimalista, usando solo tre valori: -1, 0 o 1.

Questa semplificazione, descritta già in un articolo di ricerca del 2023 e perfezionata nella nuova versione, riduce la complessità computazionale, abbattendo il fabbisogno di memoria e potenza di calcolo.

Il modello occupa appena 0,4 GB di memoria, contro i 2-5 GB di altri modelli open weight della stessa classe, e si basa su operazioni di addizione anziché moltiplicazioni, che sono molto più dispendiose. Il risultato è un'efficienza energetica che, secondo i ricercatori, varia dall'85% al 96% in meno rispetto ai modelli a precisione completa, senza sacrificare la qualità delle prestazioni su benchmark comuni.

L'impatto è evidente. Mentre i grandi modelli linguistici (LLM) come quelli di OpenAI o Meta richiedono supercomputer con migliaia di GPU, consumando enormi quantità di energia BitNet b1.58 dimostra che l'AI può funzionare su hardware modesto.

Ciò ne consente l'utilizzo su una varia gamma di dispositivi finora ritenuti "troppo scarsi" per eseguire un LLM, come laptop o smartphone, e per quelle aziende che vogliono integrare l'AI senza investire in costose infrastrutture di data center.

Questo successo nasconde un mistero: i ricercatori stessi che hanno creato BitNet ammettono di non comprendere pienamente perché essa funzioni così bene con pesi così semplificati. «Approfondire le basi teoriche dei motivi che rendono l'addestramento a 1 bit su larga scala tanto efficace rimane una questione aperta» raccontano.

Inoltre, il modello attuale è più piccolo rispetto ai giganti del settore e non è in grado di gestire contesti ampi: ciò significa che chi sogna di avere la potenza di un ChatGPT, o un Grok, o un DeepSeek sul proprio computer desktop deve ridimensionare le proprie aspettative.

Microsoft prevede comunque di continuare a perfezionare BitNet: ha messo a disposizione il codice del modello su GitHub, da dove ciascuno può scaricarlo per metterlo alla prova, e ha invitato la comunità a contribuire.

|

Se questo articolo ti è piaciuto e vuoi rimanere sempre informato con Zeus News

ti consigliamo di iscriverti alla Newsletter gratuita.

Inoltre puoi consigliare l'articolo utilizzando uno dei pulsanti qui

sotto, inserire un commento

(anche anonimo)

o segnalare un refuso.

© RIPRODUZIONE RISERVATA |

|

AMD ammette: forniture di GPU limitate per tenere alti i prezzi.

Commenti all'articolo (ultimi 5 di 8)

2-5-2025 17:37

2-5-2025 14:43

2-5-2025 14:41

1-5-2025 11:43

30-4-2025 20:05

Inserisci un commento - anche se NON sei registrato

|

|

||

|

- Pc e notebook:

Caricare pc power bank - Linux:

il mio vecchio pc con Linux - Al Caffe' Corretto:

Come sono le scuole superiori nella vostra zona? - Al caffe' dell'Olimpo:

Parliamo di musica? - Pronto Soccorso Virus:

Sito insicuro e notifiche firefox - Il salotto delle Muse:

Consigli per giovani scrittori - Tablet e smartphone:

Microsoft Surface e memoria sempre insufficiente - Software - generale:

Nomi utente su WhatsApp - Programmazione:

Come creare un documento .odt formattato - La cucina dell'Olimpo:

Vini di qualità

Homer S.