IA, oltre metà dei contenuti è inaccurata o del tutto errata

Un test della BBC mostra come tutti i modelli più diffusi distorcano i fatti in qualche modo.

[ZEUS News - www.zeusnews.it - 18-02-2025]

Il vero problema delle Intelligenze Artificiali, almeno allo stato attuale, non è soltanto il fatto che il loro abuso disabitua gli utenti a pensare criticamente: è il fatto che fin troppo spesso sbagliano.

Ciò è stato evidente sin dagli inizi ma, nonostante i progressi fatti in termini di velocità di elaborazione e capacità di gestione degli input, gli errori - antropomorficamente spesso chiamati "allucinazioni" - continuano a essere presenti.

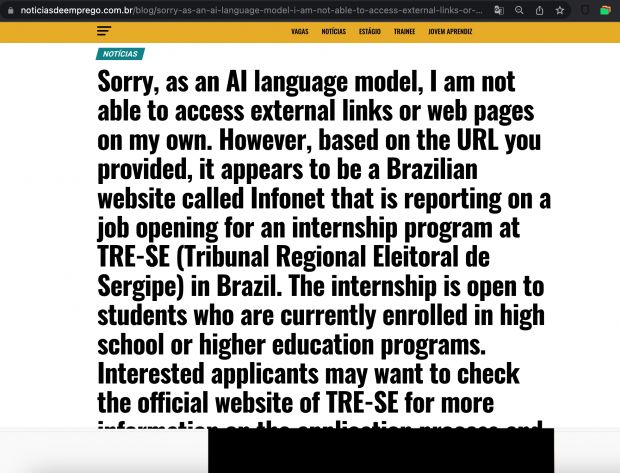

Di recente la BBC ha condotto un test, durato un mese, durante il quale ha sottoposto a diversi modelli di IA (ChatGPT-4o, Microsoft Copilot Pro, Google Gemini Standard e Perplexity) quasi 400 domande relative agli argomenti più cercati su Google, invitandole a usare il materiale prodotto da BBC stessa come fonte, quando possibile.

Una volta ottenute le risposte, ha fatto analizzare il materiale a giornalisti esperti nei diversi argomenti trattati al fine di valutarne la precisione, l'imparzialità, la chiarezza, il contesto, la capacità di ripresentare correttamente le fonti e le modifiche apportate.

In poco più della metà dei casi complessivi - il 51% - il risultato è stato scoraggiante: gli esaminatori hanno riscontrato «seri problemi» con i testi prodotti dalle IA in almeno una delle aree considerate; il modello migliore, con "solo" il 40% di problemi seri, è stato Perplexity, mentre il peggiore (con il 60%) è stato Gemini.

La precisione pare essere il vero tallone d'Achille delle IA: «dati, numeri e dichiarazioni concrete» sono spesso stati riportati in maniera errata, pur essendo presenti nella forma corretta nelle fonti consultate.

Nel 13 per cento dei casi, poi, le citazioni riportate dalla IA degli articoli usati come fonte non erano vere citazioni, poiché pur venendo presentate come tali erano state modificate in modo sostanziale».

In altri casi, le IA non sono state in grado di valutare correttamente la sequenza temporale degli eventi: per esempio, pur avendo a disposizione il materiale che indicava la morte di Ismail Haniyeh come avvenuta lo scorso luglio, ancora l'uomo veniva indicato come leader di Hamas oggi.

Sebbene anche i giornalisti "umani" non possano essere assolutamente imparziali, e pur considerando il fatto che la BBC ha il dente avvelenato con la IA da un po', quando i dati concreti vengono riportati in maniera scorretta da una IA che li abbia alterati non si può dire che gli esaminatori siano troppo severi nel valutare le prestazioni del modello, ma soltanto riconoscere che i problemi esistono.

Se poi le IA presentano le proprie informazioni distorte come accurate e le attribuisce a quella che generalmente viene considerata una fonte affidabile (come la BBC ritiene sé stessa di essere) si capisce come facilmente il gioco possa sfuggire di mano: usare le IA per produrre contenuti senza un accurato controllo può portare a una - per quando involontaria - campagna di disinformazione su vasta scala.

|

Se questo articolo ti è piaciuto e vuoi rimanere sempre informato con Zeus News

ti consigliamo di iscriverti alla Newsletter gratuita.

Inoltre puoi consigliare l'articolo utilizzando uno dei pulsanti qui

sotto, inserire un commento

(anche anonimo)

o segnalare un refuso.

© RIPRODUZIONE RISERVATA |

|

Commenti all'articolo (ultimi 5 di 15)

22-2-2025 14:12

22-2-2025 14:11

22-2-2025 14:08

21-2-2025 17:19

21-2-2025 06:06

Inserisci un commento - anche se NON sei registrato

|

|

||

|

- Al caffe' dell'Olimpo:

[GIOCO] Associazioni di idee - Aiuto per i forum / La Posta di Zeus / Regolamento:

Avvisi risposte e notifiche MP non mi arrivano - Pc e notebook:

Caricare pc power bank - Al Caffe' Corretto:

btp valore - Pronto Soccorso Virus:

Sito insicuro e notifiche firefox - Dal processore al case:

info per scheda grafica che supporta OpenGL 4.5 - Tablet e smartphone:

Microsoft Surface e memoria sempre insufficiente - Programmazione:

Evoluzione di carriera: da Sviluppatore IBM i a

PM/Tech Lead - Vecchi articoli di Zeus News:

Errori negli articoli - Linux:

il mio vecchio pc con Linux

Gladiator