IA: ChatGPT, i plugin e la responsabilità

Cassandra Crossing/ Com'era prevedibile, ChatGPT evolve verso un'architettura di API e plugin. Questo rappresenta un rischio, perché deresponsabilizza sia chi vende i servizi di GPT4 sia chi li usa.

[ZEUS News - www.zeusnews.it - 29-08-2023]

Circa due mesi fa un annuncio di OpenAI ha reso nota la realizzazione di plugin che consentono di interfacciare ChatGPT con fonti esterne di dati e servizi.

Tecnicamente, si tratta di una API che permette la realizzazione di plugin che interfacciano, anche in maniera bidirezionale, una fonte di dati o un servizio con ChatGPT (per esempio) e viceversa.

In questo modo ChatGPT può utilizzare risorse informative per produrre le sue "risposte". E nella direzione opposta gli "oggetti intelligenti", i servizi e i siti possono far generare testi, programmi e immagini alla falsa IA di turno, e utilizzarli per produrre i risultati o le pagine che devono fornire.

È perfettamente chiaro come questa architettura permetta un immediato inserimento delle false Intelligenze Artificiali nei tessuti profondi della Rete come la conosciamo oggi.

È inutile che Cassandra annoi i suoi 24 irriducibili lettori ripetendo qui la sua opinione e le sue profezie. D'altra parte, probabilmente coloro che scrivono news e commercial per guadagnarsi la pagnotta hanno già chiara la necessità di trovarsi al più presto un altro lavoro.

I loro lavori saranno infatti i primi a cadere sotto la falce dell'utilizzo delle false Intelligenze Artificiali, seguiti a ruota da un impressionante quantitativo di lavori "di concetto" e impiegatizi. Ma non è questo il tema di oggi: il tema è la responsabilità, e tutto quello che da essa si sviluppa.

L'attenzione alle questioni legali delle false IA si è per ora concentrata solo sulle questioni legate alla proprietà intellettuale, sia relativamente al materiale usato per allenare le false IA, sia relativamente alla proprietà degli output generati. Quello che i plugin impatteranno pesantemente è la responsabilità giuridica delle false IA, nel caso di danni o procedimenti civili e penali in cui esse verranno coinvolte.

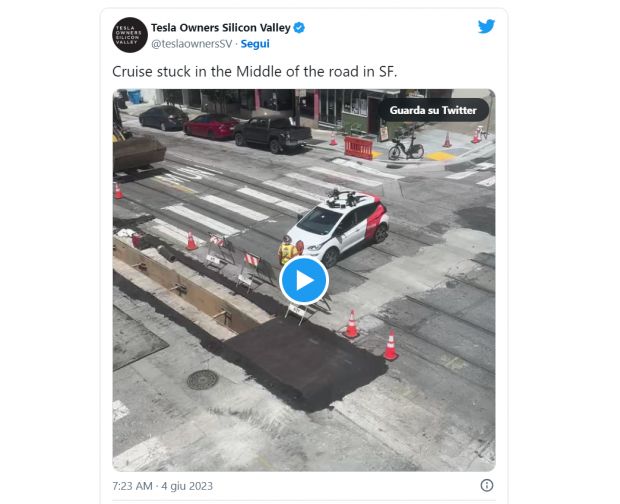

Renderanno la ricerca della responsabilità oggettiva molto più complessa, sfumata e confusa. Probabilmente improponibile ed ingestibile. Sì, perché se già oggi non c'è nessun accordo su chi dovrebbe essere il responsabile per i "cattivi comportamenti" o gli errori delle false IA e dei prodotti che le incorporeranno (automobili, cloud, armi, computer e via dicendo), la presenza di comunicazioni continue tra più false IA e tra false IA e servizi cloud, renderà una situazione giuridicamente e tecnicamente molto complessa, addirittura inestricabile per quanto riguarda le responsabilità.

Se già oggi non c'è accordo sulla responsabilità quando la falsa IA è un prodotto completamente monolitico, come un'auto a guida autonoma, figuriamoci cosa si potrà dire e fare quando le IA comunicheranno in tempo reale tra loro e con altri servizi Internet. Di chi sarà mai la responsabilità di un incidente avvenuto tra macchine cooperanti e dotate di diverse false IA, alimentate da flussi di informazioni sul traffico, sul meteo e su Dio sa cosa.

Il futuro utente-consumatore dei prossimi prodotti di questo tipo, se già non bastassero quelli già noti, dovrebbe perciò avere un motivo in più per preoccuparsi. Ah, già, il futuro è domani, e gli utenti-consumatori siamo tutti noi. Goddamn!

|

Se questo articolo ti è piaciuto e vuoi rimanere sempre informato con Zeus News

ti consigliamo di iscriverti alla Newsletter gratuita.

Inoltre puoi consigliare l'articolo utilizzando uno dei pulsanti qui

sotto, inserire un commento

(anche anonimo)

o segnalare un refuso.

© RIPRODUZIONE RISERVATA |

|

|

Scrivere a Cassandra - Twitter - Mastodon

Videorubrica "Quattro chiacchiere con Cassandra"

Lo Slog (Static Blog) di Cassandra

L'archivio di Cassandra: scuola, formazione e pensiero

Derubato, dà la colpa a Street View

Poste, migliaia di conti svuotati per colpa di una virgola

Arrestato per pedopornografia, era colpa di un virus

Guidi male? La colpa è di un gene

Apple: "Non è colpa nostra se gli iPhone esplodono"

Commenti all'articolo (5)

2-9-2023 15:49

31-8-2023 14:07

31-8-2023 12:05

30-8-2023 12:03

30-8-2023 10:31

|

|

||

|

- Aiuto per i forum / La Posta di Zeus / Regolamento:

Cambio nome - Dal processore al case:

info per scheda grafica che supporta OpenGL 4.5 - Al caffe' dell'Olimpo:

Parliamo di musica? - Tablet e smartphone:

Microsoft Surface e memoria sempre insufficiente - Pc e notebook:

Caricare pc power bank - Programmazione:

Evoluzione di carriera: da Sviluppatore IBM i a

PM/Tech Lead - Vecchi articoli di Zeus News:

Errori negli articoli - Al Caffe' Corretto:

Come sono le scuole superiori nella vostra zona? - Linux:

il mio vecchio pc con Linux - Altra ferraglia stand-alone:

Android TV e smart TV

Gladiator