Intelligenza Artificiale: GPT-4, orgasmi e Pappagalli Stocastici

Cassandra Crossing/ Distillare le cose importanti dai fatti di cronaca e da lunghi documenti tecnici non è facile, dimenticarsele invece è facilissimo; con l’uscita di GPT-4 vale la pena di ripetere tutto da zero.

[ZEUS News - www.zeusnews.it - 20-03-2023]

D'accordo, gli orgasmi degli "influencer" e di chi sta già spippolando come utente registrato su GPT-4 sono umanamente giustificati.

Gli influencer, anche i pochi competenti in materia, devono ovviamente dire cose che alzino gli ascolti, e quindi passano il tempo a pubblicare meraviglie e orrori prodotti dalle false Intelligenze Artificiali di OpenAI/Microsoft, e cercano di suscitare orgasmi e paure nei propri follower.

Gli utenti occasionali, quasi sempre del tutto ignari dei problemi delle tecnologie ICT in generale, e di quelle dell'intelligenza artificiale in particolare, sono vittime di una versione molto forte di quello che è noto come Effetto Eliza, e cadono preda di sensazioni mai provate prima, talvolta al limite dell'orgasmo.

Poiché i lettori di solito non sono informati sulle caratteristiche di base delle false Intelligenze Artificiali, hanno effettivamente tutte le ragioni di essere stupefatti, affascinati ed eccitati. Sono vittime del la Terza Legge di Clarke: «Qualunque tecnologia sufficientemente avanzata è indistinguibile dalla magia».

Enunciamo perciò i due aspetti incredibilmente ed enormemente pericolosi di questo problema. In primis: GPT-4/ChatGPT fa parte di una delle più vaste e pericolose campagne di marketing che il mondo dell'informatica abbia mai visto. È una campagna volta a incentivare l'adozione, più vasta e meno controllata possibile, di un nuovo prodotto, delle tecnologie di falsa Intelligenza Artificiale basate sul Deep Learning.

È una campagna volta a far accettare GPT-4 e i suoi simili come algoritmo tuttofare per rendere la nostra vita migliore, e risparmiarci la fatica di scegliere, prendere decisioni, essere liberi. In realtà si tratta di nuovi prodotti che solamente i GAFAM, dotati di risorse informatiche immense, possono produrre e vendere in condizioni di cartello, aprendo nuovi mercati per nuovi guadagni. Con l'assoluto disprezzo per l'etica e il bene dell'umanità che è proprio di entità non-umane come le aziende multinazionali.

In secundis: la non-intelligenza delle false "Intelligenze Artificiali" basate sulle tecnologie di Deep Learning. Questo fatto, totalmente assodato e condiviso ma volutamente sempre nascosto, la cui conoscenza è vitale, può e deve essere ripetuto instancabilmente, in forma semplice e completamente comprensibile. Un'ottima formulazione è apparsa recentemente sulla mailing list "Nexa" a opera del professor Enrico Nardelli, che qui ringrazio. In sintesi è:

GPT4/ChatGPT esibisce una competenza simile a quella degli esseri umani sul livello sintattico ma è lontana anni luce dalla nostra competenza semantica. Essa non ha alcuna reale comprensione del significato di ciò che sta facendo. Purtroppo, questo è un problema nostro di grande rilevanza sul piano sociale, poiché ciò che fa lo fa bene, esprimendosi in una forma bella e sofisticata che per noi assume un significato. Questo avviene però solo in quanto noi "proiettiamo" su di essa un significato che è in noi stessi.

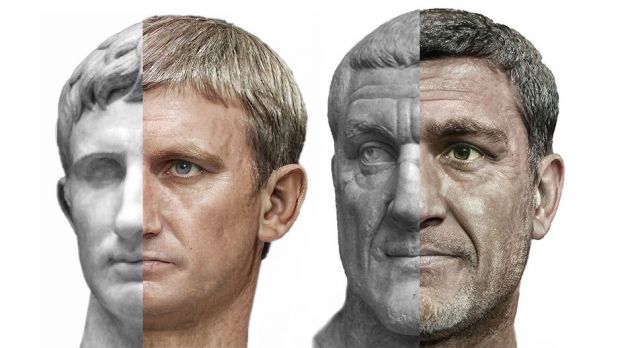

Sintassi e semantica. Linguaggio e significato. Le false Intelligenze Artificiali capiscono perfettamente le regole del linguaggio, sia esso naturale, di programmazione o addirittura visivo, e possono generare elaborati di aspetto eccellente.

Ma questi elaborati sono privi di qualunque contenuto semantico, perché le false Intelligenze Artificali non hanno la minima comprensione di quello che ricevono come domanda, e di quello che forniscono come risposta. Questi elaborati non hanno nessun significato. Non sono "veri".

Sono, per usare un'espressione nota nel settore dell'intelligenza artificiale, elaborati prodotti da "Pappagalli Stocastici", che ripetono quello che hanno sentito senza capire assolutamente nulla di un eventuale significato. E sono quindi in grado di produrre altrettanto bene il cigolio di una porta o una poesia. Chi volesse cimentarsi in una impegnativa lettura su questo, può leggere Sui pericoli dei Pappagalli Stocastici: i modelli linguistici possono divenire troppo grandi?, un paper di Emily M. Bender e altri.

Questi due problemi di fondo - ripetiamo ancora, cioè che le attuali false Intelligenze Artificiali sono:

1. un prodotto ingannevole, non "intelligenze" ma "pappagalli";- sono stati già instancabilmente ripetuti in vario modo in questa serie di 7 esternazioni di Cassandra.

2. una enorme e pericolosa operazione commerciale con sicuri impatti negativi su importantissimi aspetti della società;

L'ottava esternazione cerca di essere sintetica ma completa, per tentare di superare la cacofonia di messaggi e discussioni completamente errate e fuorvianti che dai media, sia popolari che tecnici, stanno assordando la grandissima parte degli ascoltatori.

Le attuali false Intelligenze Artificiali come quelle di OpenAI/Microsoft:

1. non sono intelligenze ma software pericolosi;

2. sono una enorme operazione commerciale svolta con totale disprezzo dei diritti umani.

E per finire, concedete alla vostra profetessa preferita un piccolo sfogo personale: che lavoro monotono e ingrato è quello della divinazione!

|

Se questo articolo ti è piaciuto e vuoi rimanere sempre informato con Zeus News

ti consigliamo di iscriverti alla Newsletter gratuita.

Inoltre puoi consigliare l'articolo utilizzando uno dei pulsanti qui

sotto, inserire un commento

(anche anonimo)

o segnalare un refuso.

© RIPRODUZIONE RISERVATA |

|

|

Scrivere a Cassandra - Twitter - Mastodon

Videorubrica "Quattro chiacchiere con Cassandra"

Lo Slog (Static Blog) di Cassandra

L'archivio di Cassandra: scuola, formazione e pensiero

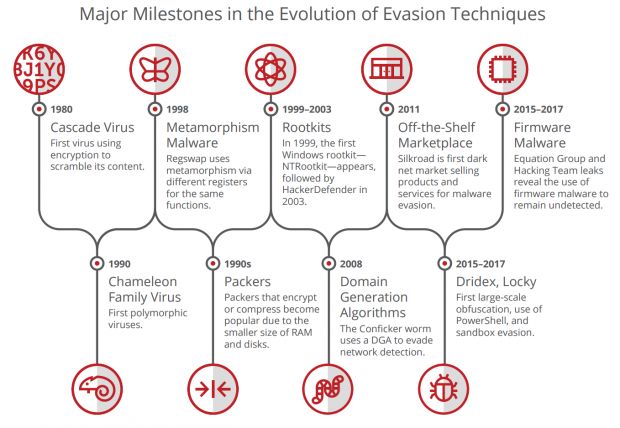

Da Cascade per MS Dos del 1980 al ramsonware e ai trojan odierni

ARM presenta le CPU per l'intelligenza artificiale

La rivoluzione della sanità grazie al digitale

La Macchina degli Incubi del MIT

Google ti conta le calorie nel piatto con una foto

Ospedali rilevano malware analizzando i flussi di elettricità

Commenti all'articolo (ultimi 5 di 22)

1-4-2023 18:32

1-4-2023 18:30

29-3-2023 19:35

27-3-2023 09:39

Inserisci un commento - anche se NON sei registrato

|

|

||

|

- Al caffe' dell'Olimpo:

[GIOCO] Associazioni di idee - Al Caffe' Corretto:

btp valore - Pronto Soccorso Virus:

Sito insicuro e notifiche firefox - Dal processore al case:

info per scheda grafica che supporta OpenGL 4.5 - Aiuto per i forum / La Posta di Zeus / Regolamento:

Cambio nome - Tablet e smartphone:

Microsoft Surface e memoria sempre insufficiente - Pc e notebook:

Caricare pc power bank - Programmazione:

Evoluzione di carriera: da Sviluppatore IBM i a

PM/Tech Lead - Vecchi articoli di Zeus News:

Errori negli articoli - Linux:

il mio vecchio pc con Linux

Gladiator