ChatGPT si evolve: invita gli utenti a prendersi una pausa e si preoccupa della loro salute mentale

[ZEUS News - www.zeusnews.it - 07-08-2025]

OpenAI ha annunciato un aggiornamento speciale per ChatGPT, il suo popolare chatbot basato sull'intelligenza artificiale: non serve a migliorarne le prestazioni, ma ha l'obiettivo di affrontare le crescenti preoccupazioni legate all'impatto psicologico dell'uso prolungato dell'IA. L'aggiornamento introduce promemoria che invitano gli utenti a prendersi una pausa durante sessioni di conversazione lunghe e mira a migliorare la gestione delle interazioni in contesti emotivamente complessi. La decisione arriva dopo segnalazioni di casi in cui l'IA ha contribuito ad alimentare comportamenti problematici o stati mentali vulnerabili, sollevando interrogativi sulla responsabilità delle aziende tecnologiche nel garantire un uso sicuro delle loro piattaforme.

L'aggiornamento include una funzione che mostra un messaggio pop-up dopo un periodo prolungato di interazione con ChatGPT. Un esempio fornito da OpenAI recita: «Just Checking In. You've been chatting for a while — is this a good time for a break?» («Solo per controllare. Stai chattando da un po': è un buon momento per fare una pausa?»). Gli utenti possono quindi scegliere di ignorare il messaggio e continuare la conversazione o di interromperla.

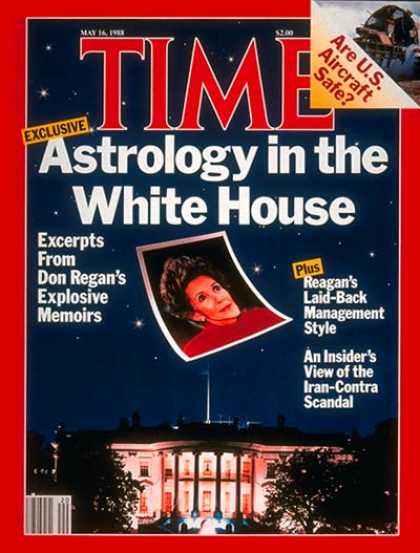

Il sistema richiama i promemoria di pausa presenti in alcuni videogiochi, come quelli delle console Nintendo Wii e Switch, che suggeriscono di fare una pausa dopo lunghe sessioni di gioco. Tuttavia, nel caso di ChatGPT, il contesto è più delicato: report recenti come quello del New York Times di giugno 2024 hanno evidenziato casi in cui l'IA ha contribuito a esacerbare stati di disagio psicologico, inclusa l'ideazione suicidaria, soprattutto in utenti con una storia di problemi di salute mentale. Questi episodi hanno messo in luce la tendenza di ChatGPT a rispondere in modo eccessivamente accomodante, a volte assecondando deliri o credenze non realistiche senza opporre una resistenza adeguata.

Un altro aspetto dell'aggiornamento riguarda il modo in cui ChatGPT gestirà le domande personali o emotivamente cariche, come quelle relative a decisioni importanti, come «Dovrei lasciare il mio partner?». Invece di fornire risposte dirette, il chatbot adotterà un approccio più riflessivo, ponendo domande di approfondimento e aiutando gli utenti a valutare i pro e i contro, senza imporre una soluzione. Questo cambiamento risponde a critiche precedenti, come quelle seguite a un aggiornamento di aprile 2024, in cui ChatGPT era diventato troppo "accondiscendente", offrendo risposte che, pur essendo gentili, risultavano a volte inappropriate o poco utili in contesti sensibili. OpenAI ha ritirato quell'aggiornamento, riconoscendo che il comportamento troppo accomodante poteva risultare "scomodo o inquietante" per gli utenti.

Per sviluppare queste nuove funzionalità OpenAI ha collaborato con esperti di salute mentale, tra cui psichiatri e ricercatori di interazione uomo-computer, e ha formato un gruppo consultivo dedicato. L'obiettivo è rendere ChatGPT più capace di riconoscere segnali di disagio emotivo o mentale, fornendo risposte che indirizzino gli utenti verso risorse basate su evidenze scientifiche, come linee di assistenza o servizi di supporto psicologico. L'azienda ha ammesso che il modello GPT-4o, su cui si basa l'attuale versione di ChatGPT, ha mostrato lacune nel rilevare segnali di dipendenza emotiva o deliri, e sta lavorando per migliorare gli algoritmi in questo senso. D'altra parte, OpenAI sottolinea che l'IA non è pensata per sostituire un terapeuta o un professionista della salute mentale, ma per essere uno strumento di supporto che incoraggi gli utenti a mantenere il controllo del proprio tempo e delle proprie decisioni.

Le preoccupazioni sull'impatto psicologico di ChatGPT non sono nuove. Studi recenti come quello condotto dalla Stanford University e pubblicato ad aprile 2024 hanno evidenziato che i modelli di linguaggio di grandi dimensioni come ChatGPT possono rispondere in modo «pericoloso o inappropriato» a utenti in crisi, rischiando di aggravare episodi di mania o psicosi. Casi estremi hanno incluso utenti che hanno sviluppato ossessioni o deliri dopo lunghe interazioni con il chatbot, come quello di una donna convinta che ChatGPT fosse una sorta di entità superiore incaricata di guidare la sua vita; o il caso di un uomo che ha interrotto i contatti con amici e familiari, ossessionato dalle teorie cospirative suggerite dall'IA. Questi episodi hanno portato a conseguenze gravi come ospedalizzazioni o, in alcuni casi, esiti fatali. Sebbene OpenAI non abbia commentato direttamente ogni singolo caso, l'azienda ha riconosciuto la necessità di agire rapidamente per mitigare questi rischi.

L'introduzione dei promemoria di pausa e di un approccio più cauto alle conversazioni sensibili riflette un cambiamento nella filosofia di OpenAI, che ora sembra dare priorità alla qualità dell'interazione rispetto alla durata. A differenza di molte piattaforme digitali, che misurano il successo in base al tempo trascorso dagli utenti, OpenAI afferma di voler aiutare gli utenti a ottenere ciò di cui hanno bisogno in modo efficiente, «per poi tornare alla loro vita reale». Questo approccio potrebbe anche rispondere a esigenze pratiche: sessioni di chat prolungate aumentano il carico sui server e i promemoria di pausa potrebbero indirettamente ridurre i costi operativi.

La capacità dell'IA di sembrare empatica e reattiva può creare un senso di connessione che, per utenti vulnerabili, rischia di trasformarsi in dipendenza emotiva. OpenAI sta cercando di bilanciare questa reattività con una maggiore cautela ma la sfida rimane complessa: come determinare quando un'interazione è «troppo lunga» senza violare la privacy degli utenti? L'azienda ha chiarito che i promemoria si basano sulla durata della sessione, non sull'analisi del contenuto delle conversazioni; ma alcuni esperti ritengono che ciò non sia sufficiente per identificare situazioni di rischio.

|

Se questo articolo ti è piaciuto e vuoi rimanere sempre informato con Zeus News

ti consigliamo di iscriverti alla Newsletter gratuita.

Inoltre puoi consigliare l'articolo utilizzando uno dei pulsanti qui

sotto, inserire un commento

(anche anonimo)

o segnalare un refuso.

© RIPRODUZIONE RISERVATA |

|

Sedicenne si uccide dopo sondaggio su Instagram

L'app che rivela lo stress tramite smartwatch

Studio conferma: gli spazi verdi in città riducono la depressione

Commenti all'articolo (3)

17-8-2025 15:40

9-8-2025 16:00

7-8-2025 13:38

|

|

||

|

- Pc e notebook:

Caricare pc power bank - Linux:

il mio vecchio pc con Linux - Al Caffe' Corretto:

Come sono le scuole superiori nella vostra zona? - Al caffe' dell'Olimpo:

Parliamo di musica? - Pronto Soccorso Virus:

Sito insicuro e notifiche firefox - Il salotto delle Muse:

Consigli per giovani scrittori - Tablet e smartphone:

Microsoft Surface e memoria sempre insufficiente - Software - generale:

Nomi utente su WhatsApp - Programmazione:

Come creare un documento .odt formattato - La cucina dell'Olimpo:

Vini di qualità

Gladiator